—

Résumé

Qu’est-ce que la « croissance numérique » ? Quelles sont ses implications sociales et écologiques ? Dans cet article, nous revenons successivement sur chacun de ces termes, avant d’esquisser quelques pistes pour l’avenir. Dans la première partie, il s’agit d’expliciter ce qu’il faut entendre par « digital growth » ou « croissance digitale » sur le plan matériel et informationnel selon un bref panorama historique. La deuxième partie s’intéresse aux enjeux sociaux en adoptant un point de vue économique critique. La troisième partie s’attache quant à elle a remettre en question l’immatérialité supposée d’Internet et du numérique en général pour en montrer les conditions matérielles et énergétique ainsi que les implications écologiques potentiellement catastrophiques. L’idée enfin de renforcer les réseaux low tech, locaux et alternatifs, d’empêcher certains usages et développements, de refuser certaines fausses solutions ou compromis, est désormais incontournable.

Texte écrit en 2021 pour compléter les actes du colloque « Les écologies du numérique » organisé par l’Ésad Orléans (ÉCOLAB) en 2017 et 2018.

—

Mots clé

croissance, digital, énergie, social, réseau

—

Biographie

Fabrice FLIPO

Philosophe des sciences et des techniques, spécialiste des grandes idées politiques, Fabrice FLIPO est professeur à Institut Mines-Télécom Business School et membre du Laboratoire de Changement Social et Politique à l’Université de Paris. Auteur de plus de quinze livres, ses recherches portent sur l’anthropologie de la modernité et de la globalisation, le développement durable, la décroissance et l’écologie des infrastructures numériques. Il a récemment publié L’impératif de la sobriété numérique (Éditions Matériologiques, 2020) et Le numérique, une catastrophe écologique (Éditions L’Echappée, 2021).

https://www.cairn.info/publications-de-Fabrice-Flipo–4637.htm

Le « digital » désigne les machines numériques, qui présentent deux caractéristiques : utiliser le langage binaire, le plus élémentaire qui soit (tout est décomposé en 0 et en 1), et la commande électronique. Chacun des deux pris séparément ne sont pas forcément très nouveaux : le binaire est proposé par Leibniz au XVIIe siècle et les propriétés de l’électronique sont utilisées depuis le début du XXe siècle notamment pour produire des télévisions électromécaniques (l’Angleterre compte un parc de 20 à 25 000 postes à cette époque) mais aussi pour compter[1]. La nouveauté vient de la machine dite « universelle », « de Von Neumann », qui permet de traiter une diversité de programmes[2]. L’informatique commence à se diffuser sous la forme de grosses machines dans les années 1950, qui voient leur taille se réduire avec la miniaturisation des composants, jusqu’à arriver à la microinformatique dans les années 1970. Des systèmes sont mis au point pour communiquer par le réseau cuivré qui est disponible. Arpanet est de petite taille, tissé entre universités dans un contexte de commandes militaires[3]. Les universités vont créer d’autres réseaux, aux États-Unis, ainsi que les informaticiens entre eux. Le premier grand réseau de terminaux est le Minitel, lancé en 1984 ; c’est un joli succès puisqu’en 1990, la France compte 6 millions d’abonnés. Le téléphone est alors filaire, souvent à cadran. La commutation des réseaux est électromécanique. Le téléphone mobile existe déjà, mais il est cher et encombrant, réservé à quelques usages précis ; le système Radiocom 2000 compte toutefois jusqu’à 60 000 abonnés, à la fin des années 1980[4]. L’arrivée des « autoroutes de l’information[5] » marque un tournant : celui d’une mise en réseau numérique des centaines de petits réseaux, d’abord aux États-Unis, puis dans le monde. En 1990, Tim Berners-Lee du CERN met à disposition son système de navigation. En 1993, Netscape Navigator[6] ouvre les portes d’un monde nouveau, offert par les possibles numériques. Le réseau ne compte encore que 130 sites web, contre près de 25 000 services Minitel ; mais quatre ans plus tard ce sont plus d’un million de sites qui sont recensés. Les PC arrivent dans les maisons au cours des années 1980, alors qu’ils sont déjà présents dans les bureaux[7]. Ils sont autour de 200 fabricants dans ces années-là, ce qui rappelle beaucoup les premières années de l’automobile, en France au tournant des XIXe et XXe siècle. Chacun assemble les composants à sa manière, cherche des usagers. La circulation des disquettes pour CDROM sont des internets lents et saccadés, mais qui préfigurent déjà les réseaux. Les systèmes analogiques radio sont remplacés par le GSM (1 ou 2 ko/s) au début des années 1990, abaissant les coûts. La 3G arrive en 2000 avec un débit 100 fois plus important, en conditions optimales (250 ko/s), ce qui suppose également de déployer un nouveau réseau d’antennes – comme ce sera de nouveau le cas avec la 4G, puis la 5G à venir.

Ces rythmes de calcul et ces débits permettent la production et la circulation d’images, textes, un défilement écran fluide : autant d’opportunités pour développer des services qui se rapprochent de ce que propose l’audiovisuel sur d’autres canaux (cinéma, télévision), ou d’autres activités, telles que les visites virtuelles (musées, conception de bâtiments etc.), les jeux ou le shopping. La fusion AOL-Time Warner illustre cette idée : le nain AOL, 15 ans d’existence et 29 millions d’abonnés sur Internet, mais valorisé en bourse à des montants extravagants, fusionne avec la vénérable entreprise de production de contenus (cinéma, télévision, presse écrite), beaucoup plus importante, et qui touche déjà des milliards d’individus. Mais l’idée n’est pas si bonne. Les canaux prolifèrent, TimeWarner reprend sa route et AOL ferme définitivement en 2018. L’idée de concilier « les » contenus existants avec « le » canal « disruptif » de diffusion, simple « nouveau support », était trop simpliste. En effet, le numérique n’est pas simplement un canal ouvrant sur le flux de conscience du consommateur : c’est l’ensemble des médiations qui se trouve changé. Comme le suggère McLuhan, le message réel est celui que diffuse l’ensemble des déformations structurelles produites dans un médium[8]. Cette déstabilisation des circulations permet à de nouveaux acteurs de trouver de nouveaux publics (Mediapart, NetFlix etc.), et de nouvelles médiations (le smartphone, la tablette). C’est aussi ce que montre Piketty, à sa manière : les périodes de croissance qui sont des moments d’ouverture sont aussi ceux au cours desquels les individus situés au bas de l’échelle ont le plus de chances de monter[9].

La circulation des biens et des services se trouve reconfigurée à tous les niveaux (inter-entreprises et dans le service au consommateur final) et dans tous les secteurs (médias mais aussi transport, construction, architecture, etc.), de manière forte ou faible suivant les cas, ce qui explique à la fois le succès mais aussi les limites des plate-formes universelles telles qu’Amazon. On se souvient qu’Internet prend modèle sur la logistique, et non l’inverse : Leonard Kleinrock, en 1961, quand il invente la commutation par paquets, part du problème de la congestion[10]. L’Internet est une machine à faire circuler. Nulle surprise que le commerce y trouve un avantage. Toutes les mises en relation sont impactées, même celui du béton, à l’image du BIM. Une plateforme, c’est avant tout de la mise en relation, du réseau, des gains sur les coûts de transaction. Uber est souvent le symbole de cette nouvelle situation ; ainsi les véhicules avec chauffeur, les chambres louées par les particuliers (AirBnB), le covoiturage (Blablacar), etc. Nathalie Sonnac suggère ainsi de considérer les médias comme des « plates-formes » d’échange[11]. À chaque fois, un « marché biface » c’est-à-dire une infrastructure de marché[12]. L’effort de R&D pour diffuser le numérique et le rendre pratique est extrêmement puissant : c’est la clé pour s’insérer de manière insensible dans les usages, créer les marchés, et attirer les revenus. L’écran devient léger, plat, mobile et constamment connecté. Il est extensible, de la montre connectée de 1,5 pouce à l’écran de Times Square de 2300 m2[13]. La petite fenêtre fixe du Minitel, à côté de la télévision, des journaux et du cinéma, n’est pas remplacée par une seule fenêtre « multimédia », comme le pensaient AOL et TimeWarner, mais par toute une gamme d’écrans, fixes ou mobiles, offrant toutes sortes de mises en relation. La loi de Moore prend fin, dans la mesure où la taille de la gravure des transistors atteint un palier ; mais le nombre de transistors prend le relais, ouvrant sur un monde numérique dont la qualité visuelle finit par être proche de celle du monde saisi sans la médiation d’un écran (Oled 4K).

Le rapport Théry de 1994 sur les « autoroutes de l’information[14] » voit très bien arriver la fusion de l’information, des télécommunications et de l’audiovisuel, mais il n’anticipe ni l’émergence des réseaux sociaux, qui permettent la création de contre-espaces publics tels que ceux que l’on voit encore avec les Gilets Jaunes, ni la pluralisation industrielle du monde de l’attention[15], ni la dimension logistique de l’Internet, qui propose aujourd’hui 182 000 sites marchands, rien que pour la France. Le numérique n’est pas seulement une technique ou industrie de l’esprit, individuel ou collectif. C’est aussi une manière de transformer le monde, et pas seulement de l’interpréter. Le numérique est un système matériel de commande : le programme exécute des ordres, qui commandent des machines. La machine-outil à commande numérique arrive dans les années 1980, précédée de la machine à bande magnétique, elle-même précédée de la machine à cartes perforées. En 2000 la France comptait 380 000 machines de ce type[16]. Placés dans des boucles de rétroaction, les programmes peuvent « apprendre », ou du moins évoluer dans leur structure en fonction des événements qu’ils détectent, jusqu’à ne plus pouvoir être entièrement prévisibles, singeant ainsi la liberté. L’intelligence artificielle n’en est que le prolongement sophistiqué. L’ensemble de l’organisation du travail évolue avec la présence grandissante des algorithmes, qui ne sont rien d’autres que des programmes numériques. On parle d’« Internet physique », de coordination de l’ensemble des mouvements physiques d’une entreprise à partir d’un seul réseau interconnecté[17]. Le conteneur modulaire est le pendant matériel du bit, dans la circulation économique. Ce n’est pas entièrement nouveau : le monde industriel est celui des machines, du feu[18], celui qui a choisi de « motoriser le monde », au point de penser parfois remplacer celui qu’Aristote appelait le Premier Moteur : Dieu lui-même. C’est le rêve transhumaniste.

Qu’est-ce que le social ? À l’époque de la modernité, ce concept renvoie d’abord à la répartition de la valeur ajoutée, et plus largement au contrôle collectif de notre destin. Le Capital met en scène l’opposition entre le capitaliste et le travailleur, dans une lutte dialectique[19], à la suite du Maître et de l’esclave de Hegel[20]. Le capitaliste cherche à valoriser son capital, à le reproduire de manière élargie. Dans ce but, il dispose de deux leviers principaux : l’allongement de la journée de travail, ou plus-value absolue, et l’évolution technologique, ou plus-value relative. Au XIXe siècle, la journée de travail est longue et pénible, mais les luttes des ouvriers, bientôt structurés en syndicats (légalisés par la loi Waldeck-Rousseau de 1884), permettent de la réduire, de manière tendancielle, jusqu’à la semaine dite « de 35 heures », en France à la fin des années 1990 ; la durée moyenne effective de travail se situe plutôt autour de 40 heures, mais avec 5 semaines de congés payés, ce qui conduit à 1400 heures par an, contre 2100 en 1960[21]. De même que « l’économie » renvoie généralement à l’action des entrepreneurs, dans la bouche des libéraux[22], « le social » renvoie le plus souvent au mouvement social organisé, du côté des socialistes. Ce sont deux descriptions hétérogènes et antagoniques de l’ordre social, relatives à deux positions différentes de l’ordre productif. Pour le libéralisme la société s’auto-organise, via l’intérêt marchand, il suffit d’assurer l’égalité et l’état de droit. Le socialisme estime que l’échange n’est pas libre et que les travailleurs courent des risques disproportionnés ; le mouvement ouvrier met peu à peu en place ce filet de sécurité connu sous le nom de sécurité sociale et qui couvre la vieillesse, la maladie et le chômage.

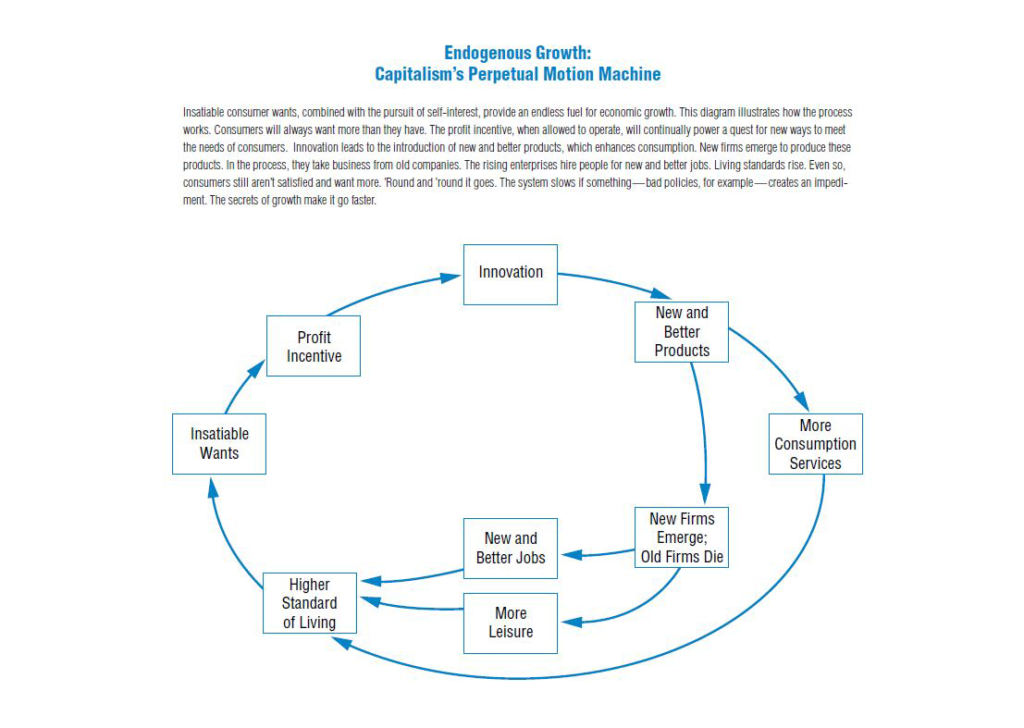

Source : Federal Reserve Bank of Dallas 1993 Report, p. 25.

Avec les travaux de Thomas Piketty[23], la courbe en éléphant[24] illustre bien ce qui s’est produit ces dernières années : forte croissance du 1 % le plus riche, tassement voire réduction du niveau de vie de la classe moyenne dans les pays développés, croissance de la classe moyenne des pays en développement, et relative stabilité des plus bas revenus à l’échelle globale. La troisième révolution industrielle que représente le numérique n’est pas neutre dans cette évolution : il est souvent l’outil privilégié, avec la baisse des droits de douane (libéralisation) et la généralisation du transport par conteneur ; il suffit pour cela de comparer les salaires très élevés de ce secteur (Google etc.) et ceux très bas des « travailleurs du clic[25] », même si c’est réducteur, dans la mesure où bien d’autres métiers sont occultés. Le numérique « disrupte » les marchés classiques mais facilite aussi la délocalisation des entreprises et la restructuration « en réseau » des firmes, voire des villes[26]. Les grandes fortunes récentes sont largement issues du numérique ou de transformations économiques facilitées par le numérique, telles que la « fast fashion » du groupe Inditex, qui impose un temps très court entre la conception du produit et sa mise en vente[27]. Les nouvelles chaînes de valeur qui se mettent en place ne sont pas avantageuses pour tous. Le numérique devient tyrannique : après la joie d’être connecté, et de commander la machine, liée aux gains en autonomie, la bataille pour le droit à la déconnexion, et la lutte contre le rythme imposé par la machine[28]. Le salariat tend à régresser, au profit de contrats de sous-traitance mal encadrés par le droit existant, et coupés de la protection sociale. Dans d’autres cas cependant, la plate-forme ouvre de vraies opportunités de collaboration[29] , voire organise un travail qui jusque-là était assuré principalement par des indépendants (par exemple, les taxis). Certaines analyses s’alarment d’un effondrement possible de l’emploi, oubliant que les machines n’inventent pas le sens seules, et ne « remplacent » donc jamais à proprement parler l’être humain dans l’aventure humaine ; de plus dans l’approche marxiste l’origine de l’activité est dans le travail et non dans les machines, celui-ci ne peut donc que se redéployer ailleurs, ce qu’avait également perçu Schumpeter. De là l’ambiguïté des plates-formes : nouvelles formes socialistes de coopérer ou retour du tâcheronnage ? Elles sont les deux, suivant les cas. Les États savent aussi en tirer profit puisque la dynamique économique renforce leur puissance[30] . Nouvelle abondance, se livrant à qui saura s’en saisir, le numérique est présenté comme la solution universelle, notre Destin. « Croissance, emplois et services sont les avantages les plus importants qu’apportent les investissements dans le numérique. […] les technologies numériques aident les entreprises à devenir plus productives ; les populations à trouver des emplois et élargir leurs possibilités, et les pouvoirs publics à fournir des services de meilleure qualité à tous[31] ». Pourtant il y a loin de la coupe à la bouche : derrière les promesses, la « fracture numérique », et la réalité des algorithmes stupides, qui multiplient les obstacles, plutôt que de simplifier la vie – que l’on pense aux automates téléphoniques des grandes sociétés. Dans le même temps l’accès au réseau devient indispensable, car les alternatives sont progressivement supprimées : 65 % des Français pense qu’Internet est important ou très important pour se sentir intégré dans notre société[32] ; 39 % sont inquiets face aux démarches administratives en ligne[33].

Le numérique est accompagné dans un premier temps d’une image de légèreté et d’immatérialité. Dominique Wolton, à la fin des années 1990, décrivait ainsi le numérique comme transparent, léger, immatériel, soft, instantané, propre et sans nuisances, de là peut-être, disait-il, un lien avec l’écologie[34] . Au niveau législatif rien n’est entrepris avant les années 2000 pour traiter ses déchets, par exemple. L’information est de la néguentropie, arguait-on déjà dans les années 1970 ; elle permet d’aller contre les funestes avertissements de Nicholas Georgescu-Roegen[35] et du Club de Rome[36]. Les technologies de l’information et de la communication (TIC) ne produisent rien d’autre, à première vue, que de la mise en relation. Or c’est justement ce qui manque, semble-t-il : davantage de mise en relation ne pourrait conduire qu’à une société mieux (auto)contrôlée, donc contrôlant mieux sa trajectoire dans la biosphère. Les TIC apporteraient donc « la maîtrise de la maîtrise » cherchée par Michel Serres dans son Contrat naturel[37] : « Le salut de la planète, la cohésion sociale et la reprise de la croissance sous une nouvelle forme semblent passer par la réussite et la vitesse de cette révolution[38] ». Mais en 2007, Gartner, le cabinet d’étude de référence dans le secteur du numérique, révèle que le secteur des TIC est à l’origine d’une quantité de gaz à effet de serre comparable à celle produite par l’aviation : 2 % des émissions globales. Le chiffre émeut le secteur. Déstabilisé, il contre-attaque : se concentrer sur les 2 %, c’est oublier les 98 % restants, argue-t-il, pour la réduction desquels le numérique est la solution. À l’échelle mondiale, le potentiel de réduction des émissions de gaz à effet de serre serait de 15 à 30 %, d’ici 2020[39]. Ces chiffres sont largement repris par les autorités publiques, et même par certaines ONG[40].

Qu’est-ce que « l’enjeu écologique » ? L’écologie désigne une science, née vers la fin du XIXe siècle ; le mot apparaît sous la plume d’Ernst Haeckel en 1866[41]. C’est une science de la nature entendue comme biosphère, lieu où la vie a lieu en permanence[42]. Pour aller au fait, l’enjeu écologique est l’Anthropocène, à savoir une modification potentiellement catastrophique de la biosphère, de la part d’une seule espèce, l’humanité, et cela suivant des responsabilités différenciées.

L’espoir est-il fondé ? Les données 2019, à la veille de 2020, indiquent que le résultat espéré est totalement absent : le numérique a été massivement diffusé mais les GES mondiaux n’ont pas été réduits ; au contraire, ils ont augmenté, et la part du numérique a augmenté plus vite que celle de l’aviation, dépassant les pires scénarios. Entrons dans le détail. Le débat se structure en trois parties distinctes, souvent renvoyées à l’article de Berkhout et Hertin[43] : l’impact du numérique en tant que tel, de manière brute et physique ; les effets du déploiement du numérique sur les styles de vie, tels que les transports, la communication, l’information ; et les transformations plus larges, sur les genres de vie.

Le premier point exige de mettre quelques chiffres en avant de manière à éclairer les enjeux. Ces chiffres ressortent de trois grandes catégories, gérées de manière distinctes par les réglementations : la consommation d’énergie, la matière et les toxiques[44]. La première est indubitablement tirée par l’appel en puissance de calcul, et en second la production des équipements, à base de métaux rares et donc coûteux en énergie. Le poids de la vidéo est souvent mis en avant : elle représente certes 51 % du trafic mondial, mais l’énergie consommée vient de ce que les fichiers vidéo sont des programmes, qui programment du calcul, qui déterminent l’allumage ou l’extinction de pixels. Plus les pixels sont nombreux (4K, 8K, rafraîchissement rapide, etc.), plus la vidéo consomme. Le jeu pèse donc facilement très lourd : il passe de 1 % du trafic mondial en 2016 à 3 % en 2020. Un jeu comme Grand Theft Auto pesait 360 Mo en 1996 ; en 2020 : 200 Go. Cette augmentation rapide est compensée par l’efficacité énergétique, jusqu’ici, à tel point que la consommation du numérique en France a stagné voire légèrement baissé sur les dix dernières années, malgré les hausses indiquées ; nous restons entre 10 et 15 % de la consommation électrique nationale, depuis 2008, soit quand même 8 réacteurs nucléaires[45]. Si Internet était un pays, il serait le 3e plus gros consommateur d’électricité au monde avec 1500 tWh par an (100 réacteurs nucléaires), derrière la Chine et les États-Unis[46]. Google consomme 5 GW, soit 5 réacteurs nucléaires ; Amazon 700 MW, Facebook 400[47]. Au total, le numérique consomme 10 à 15 % de l’électricité mondiale. Et cette consommation double tous les 4 ans, car la situation française n’est pas représentative de la croissance mondiale. Et en 2015 l’industrie des semi-conducteurs indiquait l’existence d’une borne physique ultime : la « limite de Landauer », quantité d’énergie dépensée en-deçà de laquelle aucune différence ne peut plus être produite entre un 0 et un 1 ; au rythme de croissance de la demande de calcul, cette limite physique théorique conduirait à ce que la totalité de l’énergie mondiale actuelle soit consacrée à la puissance de calcul, autour de 2070[48].

Un second volet des impacts directs est la matière. De l’époque du Minitel à celle de l’Iphone X, la quantité de matière consommée a fortement augmenté, en quantité comme en qualité. Le téléphone à cadran contenait 12 éléments minéraux distincts, parmi lesquels aucun n’était « critique ». Un smartphone contient 55 éléments, dont 22 critiques[49]. Le numérique consomme 95 % du gallium mondial, 66 % du ruthénium, 34 % du tantale, 15% du palladium, 12,5 % du cuivre, pour n’en citer que quelques-uns[50]. La collecte des déchets est déficiente : la France est incapable de savoir ce que devient 40 % d’entre eux[51]. Des continents entiers sont dénués de système de traitement ; il est vrai que ce sont ceux qui consomment le moins de numérique[52]. Au niveau européen, la directive DEEE a maladroitement tenté de favoriser une concurrence vertueuse, vers des produits plus écologiques, mais s’en est tenue à organiser des filières de recyclage matériel, sans réemploi ni lutte contre l’obsolescence accélérée[53]. La directive ROHS par contre a fait baisser le taux de toxiques dans les produits neufs, il ne reste que les bromures utilisés dans un usage anti-incendie, mais les plastiques posent le même problème que partout ailleurs.

La numérisation n’a pas réduit l’empreinte écologique des modes de vie. D’après l’OCDE, les politiques actuelles amèneraient le monde à consommer deux fois plus de matériaux en 2060 qu’aujourd’hui, passant de 89 Gt en 2011 à 167[54]. Elle avait déjà augmenté de 27 Gt en 1970 à 89 en 2017. Ce scénario « tendanciel » suppose que les politiques restent inchangées et qu’il n’y aura pas d’effets perturbateurs tels que le changement climatique ou des conflits, autant dire que sa réalisation semble peu probable[55]. Il sert plutôt d’indicateur, pour mesurer l’ampleur des changements à effectuer. Le rapport du PNUE fait état de prélèvements plus importants encore : 183 Gt en 2050[56]. Un rapport de l’OCDE sur les transports indique clairement le problème : tant que les politiques ne seront pas changées, le numérique sera mis au service de la croissance des kilomètres parcourus, par les marchandises comme par les êtres vivants (humains ou animaux), conduisant à la croissance très forte des GES, en l’absence de changement miraculeux du système technique[57]. C’est la leçon du scénario « sobriété » du Shift project : même en limitant certains usages, d’autres croissent, et en croissant, finissent par rattraper l’efficacité énergétique, par le simple fait qu’ils croissent et ne décroissent jamais, alors que rien, en physique, ne peut être « plus efficace » à l’infini. Le numérique a produit cette fausse idée d’infini, de « copier-coller à coût zéro », que nous critiquions dans nos premiers travaux sur le sujet comme étant profondément trompeuse[58].

Qu’est-ce qu’un réseau ? C’est une organisation des circulations. Il existe des réseaux écologiques, énergétiques, machiniques ; des réseaux occultes, de connivence, d’entraide et même d’information. Hier encore nous n’avions pas de réseaux numériques, et nous vivions très bien ; aujourd’hui le numérique est si présent qu’il devient inimaginable de s’en passer, dès lors tout ce qui précède paraît n’avoir été qu’illusion. Libéraux, productivistes et « accélérationnistes[59] » ont largement dû se rendre à l’évidence : nous sommes dans l’Anthropocène, qui désigne une manipulation non-maîtrisée de la nature, à une échelle potentiellement catastrophique. Il n’y a pas de « ruse de l’histoire ». Que faire ? Renforcer les réseaux low-tech, locaux, alternatifs, leur accorder notre attention, se déconnecter des autoroutes mortifères, circuler autrement. Ne pas faire la 5G, limiter la consommation d’énergie des IA, ne pas faire la voiture autonome, alléger les sites web. Se méfier de la compensation carbone, dans la mesure où elle peut aussi servir à renforcer les pratiques destructrices. Arrêter de se poser la question en termes purement individuels, ou purement étatiques : toujours se dire que nous sommes en réseau, et que ce qui compte, c’est les circulations que nous encourageons, et celles que nous empêchons d’émerger, directement ou indirectement.

[1] Patrice FLICHY, Une histoire de la communication moderne : espace public et vie privée, Paris, Éditions La Découverte, 1991, p. 195.

[2] Norbert WIENER, La cybernétique. Information et régulation dans le vivant et la machine, Paris, Éditions du Seuil, 2014 (1947) ; Norbert WIENER, Cybernétique et société, Paris, Éditions Deux Rives, 1949.

[3] Philippe BRETON, Une histoire de l’informatique, Paris, Éditions du Points, 1990.

[4] Le DynaTac de Motorola commercialisé en 1983 pesait environ un kilogramme pour 25 centimètres de longueur ; sa batterie offrait 30 minutes d’autonomie pour presque 10 heures de chargement, pour la somme de 3 995 $. Le MicroTac de Motorola en 1989 mesure 23 cm de long, et coûte à peine moins cher.

[5] Gérard THÉRY, Les autoroutes de l’information, Rapport au Premier Ministre, 1994, [en ligne], https://www.ladocumentationfrancaise.fr/var/storage/rapports-publics/064000675.pdf

[6] En fait les « précurseurs » sont plus nombreux, Mosaic, WorldWideWeb etc.

[7] https://www.zdnet.fr/actualites/les-pionniers-de-l-informatique-11-machines-stars-des-annees-1970-39374505.htm?p=3

[8] Marshall MCLUHAN, Pour comprendre les médias. Les prolongements technologiques de l’homme, Paris, rééditions du Seuil, 1977 (1964).

[9] Thomas PIKETTY, Le capital au XXIe siècle, Éditions du Seuil, 2013.

[10] https://www.lk.cs.ucla.edu/data/files/Kleinrock/Information%20Flow%20in%20Large%20Communication%20Nets.pdf

[11] Nathalie SONNAC, « Les médias : une industrie à part entière et entièrement à part », Questions de communication, n°9, 2006, [en ligne] consulté le 02 octobre 2021, http://journals.openedition.org/questionsdecommunication/7947 ; DOI : https://doi.org/10.4000/questionsdecommunication.7947

[12] Nicolas CURIEN, Economie des réseaux, Paris, Éditions La Découverte, 2000.

[13] 160 MW pour les 55 écrans LED de Times Square, [en ligne], https://www.businessinsider.fr/us/the-cost-of-lighting-landmarks-around-the-world-2017-7

[14] Gérard THÉRY, op.cit.

[15] Yves CITTON, L’économie de l’attention. Nouvel horizon du capitalisme ?, Paris, Éditions La Découverte, 2014 ; Bernard STIEGLER, La technique et le temps, Paris, Éditions Fayard, 2018, p. 685. ; Chris ANDERSON, The long tail, Wired, 10/01/2004, [en ligne], https://www.wired.com/2004/10/tail/

[16] SESSI, Le 4 pages des statistiques industrielles, n°121, octobre 1999, [en ligne], https://www.epsilon.insee.fr/jspui/bitstream/1/56433/1/4p121.pdf

[17] https://www.usinenouvelle.com/article/l-internet-physique-atout-de-la-supply-chain.N383723

[18] Alain GRAS, Le choix du feu : aux origines de la crise climatique, Paris, Éditions Fayard, 2007.

[19] Karl MARX, Le Capital, Livre 1, Paris, Éditions PUF, 1993 (1867).

[20] G.W.F. HEGEL, La phénoménologie de l’esprit, Paris, Éditions Flammarion, 2012 (1807).

[21] Jean GADREY, « La durée moyenne du travail est passée à 31h en 2010. En Allemagne, elle est de 29h ! », Reporterre, 27 mai 2013, [en ligne], https://reporterre.net/La-duree-moyenne-du-travail-est

[22] Par exemple Pierre-Joseph PROUDHON, Les Malthusiens, 1849.

[23] Thomas PKETTY, Le capital au XXIe siècle, op. cit.

[24] Christoph LAKNER, Branco MILANOVIC, Global income distribution, Rapport sur l’évolution des salaires dans le monde, Banque Mondiale, 2013, [en ligne], https://www.gc.cuny.edu/CUNY_GC/media/CUNY-Graduate-Center/PDF/Centers/LIS/Milanovic/papers/2013/WPS6719.pdf

[25] Antonio CASILLI, En attendant les robots : Enquête sur le travail du clic, Paris, Éditions du Seuil, 2019.

[26] Guillaume FABUREL, Les métropoles barbares, Paris, Éditions du Passager Clandestin, 2018.

[27] Kathleen CHAYKOWSKI, « Welcome To The Billionaires’ Club: 195 Newcomers Worth $362 Billion », Forbes, 05 mars 2019, [en ligne], https://www.forbes.com/sites/kathleenchaykowski/2019/03/05/welcome-to-the-billionaires-club-195-newcomers-worth-362-billion/#a7382ca42156

[28] Voir le numéro spécial Sociologies pratiques, Le numérique (dés)organise-t-il le travail? 2017, n°134, [en ligne], https://www.cairn.info/revue-sociologies-pratiques-2017-1-page-3.htm

[29] Eloi LAURENT, L’impasse de l’économie collaborative, Paris, Éditions Les Liens qui Libèrent, 2018.

[30] François FOURQUET, Les comptes de la puissance. Histoire de la comptabilité nationale et du plan, Paris, Éditions Encres, 1980.

[31] Rapport sur le développement dans le Monde, Banque Mondiale, 2016.

[32] Patricia CROUTTE, Sophie LAUTIÉ, Sandra HOIBIAN (dir.), Baromètre numérique, 2016, op. cit.

[33] https://www.entreprises.gouv.fr/observatoire-du-numerique/e-administration-la-double-peine-des-personnes-difficulte

[34] Dominique WOLTON, Penser la communication, Paris, Éditions Flammarion, 1997, p. 249.

[35] Nicholas GEORGESCU-ROEGEN, The Entropy Law and the Economic Process, Cambridge, Éditions Harvard University Press, 1971. Traduction : La décroissance, Paris, Éditions Sang de la Terre, 2006.

[36] Club de Rome, Halte à la croissance ?, Paris, Éditions Fayard, 1972 (1971).

[37] Michel SERRES, Le contrat naturel, Paris, Éditions Flammarion, 1999 (1990).

[38] Sylvie FAUCHEUX, Christelle HUE, Isabelle NICOLAÏ, TIC et développement durable – Les conditions du succès, Paris, Éditions De Boeck, 2010.

[39] GeSI, SMART 2020 Enabling the low-carbon economy in the information age, 2008, [en ligne], https://gesi.org/report/detail/smart-2020-enabling-the-low-carbon-economy-in-the-information-age

[40] WWF Sweden, The potential global CO2 reductions from ICT use, 2008, [en ligne], https://d2ouvy59p0dg6k.cloudfront.net/downloads/identifying_the_1st_billion_tonnes_ict_academic_report_wwf_ecofys.pdf

[41] Ernst HAECKEL, Histoire de La Création Des Êtres Organisés d’après Les Lois Naturelle, 1884, Gallica.

[42] Vladimir VERNADSKY, La biosphère, Paris, Éditions Alcan, 1929 (1926).

[43] Frans BERKHOUT, Julia HERTIN, Impacts of information and communication technologies on environmental sustainability: speculations and evidence, 2001, Rapport à l’OCDE.

[44] Fabrice FLIPO, Michelle DOBRÉ, Marion MICHOT, La face cachée du numérique, Paris, Éditions L’Echappée, 2013 ; Fabrice FLIPO, François DELTOUR et alii, Peut-on croire aux TIC vertes ? Technologies de l’information et crise environnementale, Paris, Presses de Mines, 2012.

[45] Association NEGAWATT, La révolution numérique fera-t-elle exploser nos consommations d’énergie ?, 07/12/2007, [en ligne], https://decrypterlenergie.org/la-revolution-numerique-fera-t-elle-exploser-nos-consommations-denergie

[46] Greenpeace, Make IT green – cloud computing and its contribution to climate change, mars 2010, [en ligne], https://www.greenpeace.org/static/planet4-international-stateless/2010/03/f2954209-make-it-green-cloud-computing.pdf

[47] Greenpeace, Clicking green, 2016, [en ligne], http://www.clickclean.org/international/en/

[48] http://large.stanford.edu/courses/2016/ph240/vega1/docs/ritr-2015.pdf

[49] Guillaume PITRON, La guerre des métaux rares : la face cachée de la transition énergétique et numérique, Paris, Éditions Les Liens qui libèrent, 2018.

[50] Ibid.

[51] CWIT, Countering WEEE Illegal trade, 2015.

[52] http://ewastemonitor.info/

[53] Fabrice FLIPO, Michelle DOBRÉ, Marion MICHOT, La face cachée du numérique, op. cit.

[54] OCDE, Global Material Resources Outlook to 2060 : Economic Drivers and Environmental Consequences, Éditions OCDE, Paris, 2018, [en ligne], https://doi.org/10.1787/9789264307452-en

[55] Hughes-Marie AULANIER, « Prospective inutile ou déni dangereux ? », 16 Novembre 2018, [en ligne], http://www.carbone4.com/prospective-inutile-deni-dangereux/

[56] UNEP, International Resource Panel, International Trade in Resources, United Nations Environment Programme, 2015. En grande partie basé sur Dittrich 2012.

[57] FIT, ITF Transport Outlook 2019, Éditions OCDE, Paris, 2019, [en ligne], https://doi.org/10.1787/transp_outlook-en-2019-en.https://read.oecd-ilibrary.org/transport/itf-transport-outlook-2019_transp_outlook-en-2019-en

[58] Fabrice FLIPO, Annabella BOUTET et alii, Écologie des infrastructures numériques, Paris, Éditions Lavoisier et Hermès Sciences, 2007.

[59] Alex WILLIAMS, Nick SRNICEK, « Manifeste accélérationniste », Multitudes, no 56, 2014, p. 23‑35, [en ligne], www.multitudes.net/manifeste-accelerationniste/