—

Résumé

La vocation de ce projet éditorial est de proposer une réflexion collective et multidimensionnelle sur les conditions et les modalités des écologies du numérique (matérielle, psychique, sociale et politique). Cette réflexion est menée de manière conjointe à travers des analyses de pratiques de conception, de production, de diffusion et d'usage propres au design au sens large (design objet, design graphique, design éditorial), et à travers des projets d'artistes et de designers confirmé·e·s, comme d'étudiant·e·s de 2e cycle à l'ÉSAD Orléans, qui interrogent les effets du système numérique sur les milieux naturels et artificiels tout en proposant de nouvelles pratiques de conception et de partage des savoirs. Dans cette introduction, il s'agit avant tout de poser les enjeux d'une pluralisation de l'écologie, puis des significations d'un horizon post-numérique, et enfin des raisons motivant une édition en web to print.

Text écrit en 2021 et actualisé en 2022 pour la publication des actes augmentés du colloque "Les écologies du numérique" organisé par l'ÉSAD Orléans (ÉCOLAB) en 2017 et 2018.

—

Mots clé

Écologie, Design, Numérique, Édition, Post-numérique, Savoir

—

Biographie

Ludovic DUHEM

Ludovic Duhem est philosophe et artiste. Il enseigne la philosophie dans des écoles supérieures d'art et de design en France et à l'étranger, ainsi qu'à l'université. Actuellement coordinateur de la recherche à l'ÉSAD Valenciennes, il était responsable de la recherche de l'ÉSAD Orléans de 2010 à 2019 et directeur de l'UR ÉCOLAB de 2016 à 2019. Ses recherches portent sur les relations entre esthétique, technique et politique en lien avec les enjeux écologiques. Site web : www.ludovicduhem.com.

—

Ce projet éditorial porte sur les conditions et les modalités d’une conception "écologique" du numérique à travers les pratiques contemporaines de design. Il repose plus précisément sur l’idée que l’écologie est irréductible à l’étude scientifique des écosystèmes et à l’engagement pour la protection de la nature, et qu’elle doit par conséquent se comprendre au sens large comme une approche relationnelle, dynamique, scalaire et complexe pouvant s’appliquer non seulement aux milieux naturels mais aussi aux milieux artificiels, et en particulier au milieu numérique devenu aujourd’hui le milieu associé de nos existences humaines, c'est-à-dire ce qui donne des conditions et des significations nouvelles à nos manières de sentir, de penser et d'agir.

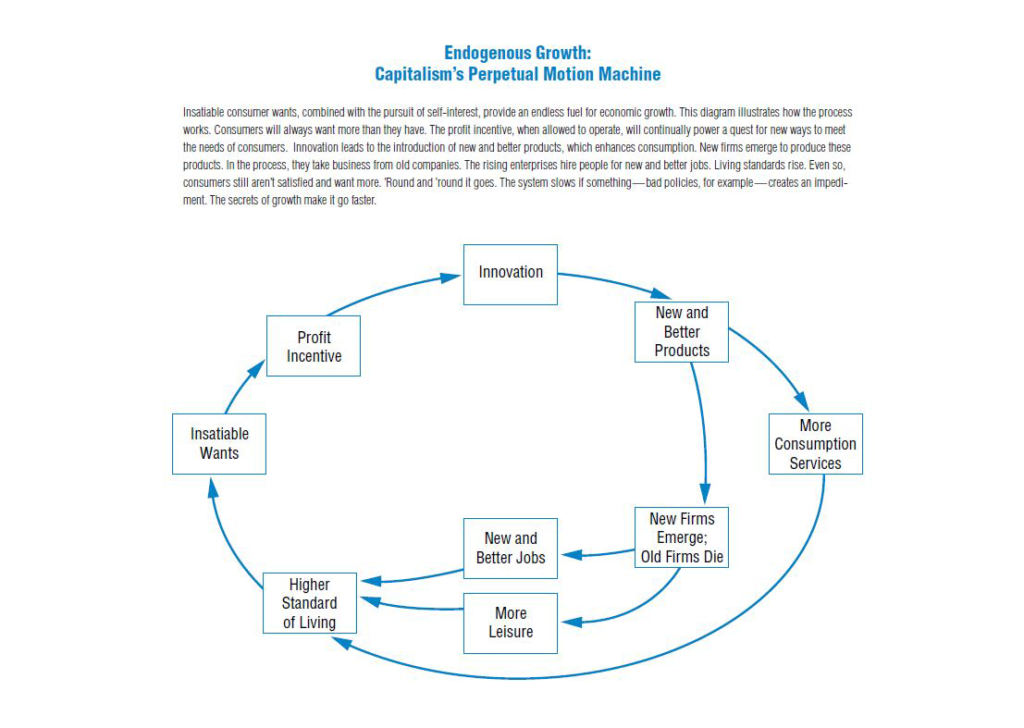

À ce titre, l’élargissement de l’écologie appliquée au numérique n’est pas une naturalisation de la technique qui ferait des objets numériques des êtres autonomes vivant au sein d’écosystèmes isolés de la toxicité des conditions industrielles de leur production, de la dépense énergétique considérable de leur utilisation et des effets nocifs de leur destruction (ce que la cybernétique a pu longtemps laisser croire et que la logique d'effacement technocapitaliste poursuit aujourd'hui). Ce n’est pas non plus une manière de fonder la sortie de la crise écologique (si cette crise peut être clairement circonstanciée et n’être qu’un moment de notre histoire commune) sur le développement exclusif des technologies numériques. Cela signifierait avoir recours à un technicisme naïf reprenant le mythe moderne du progrès (irrésistible, infiniment désirable, intégralement rationnel et intrinsèquement bon) pour le transférer dans la "société de la connaissance" (grâce à la puissance de calcul, de simulation et de réticulation de la rationalité computationnelle) et de l'idéologie de l' "innovation permanente" (dont le sens est économique plutôt que technique), tout en ignorant volontairement que ce transfert implique en même temps la transformation du savoir en marchandise, l'accroissement du travail gratuit, et le contrôle de la vie individuelle et collective (donc une prolétarisation généralisée par la perte de savoir-faire, de savoir-être, de savoir-vivre et de savoir concevoir).

Au contraire, il est question d’opérer une véritable critique de l'hypermodernité numérique, celle du calcul automatique généralisé et de la transformation intégrale de toutes les dimensions de la réalité du niveau nanophysique au niveau cosmologique. Cette "critique" n’est pas une opposition à toute forme de "modernité" (exigence de rationalité, d’universalité et d’émancipation en font partie) ni au "numérique" comme tel (comme technique, industrie et média), mais une démarche de questionnement sur les conditions de sa constitution, de son évolution, de son fonctionnement et de ses effets. C’est aussi une recherche de dépassement des alternatives classiques entre humanisme et technicisme d’une part, humanisme et écologisme d’autre part, lesquelles limitent aussi bien la compréhension de la complexité de la crise écologique planétaire que la réussite des actions proposées pour la résoudre.

Selon une telle perspective critique, ce projet éditorial propose de pluraliser l’écologie en questionnant le numérique sur le plan de l’écologie matérielle (ressources, risques et alternatives), de l’écologie psychique (capture de l’esprit et design du savoir), de l’écologie sociale (transformation de l’identité, conditionnement des communautés, contrôles des échanges), de l’écologie politique (nouvelles formes d’exploitation et de lutte, de participation et d’organisation). Or, ces différents plans ne sont pas de simples catégories conceptuelles commodes pour traiter la question de l’écologie du numérique obtenues par son éclatement en aspects isolés, ce sont en réalité les dimensions du même problème, et plus encore les modes d’existence d’une même réalité qui se superposent, se heurtent, se plissent, se fracturent, au sein d’une situation tout à fait nouvelle. Plus précisément, en tant que le numérique tend désormais à transformer l’ensemble des relations entre la Terre et les êtres humains, mais aussi entre les humains et les artefacts, entre les humains et entre les artefacts eux-mêmes devenus autonomes et interconnectés ; il semble décisif de questionner non seulement l’impact écologique du numérique (ses effets physiques, biologiques, psychiques, sociaux, politiques) mais aussi l’impact du numérique sur l’écologie (comme science, discours, action, mobilisant les technologies numériques). À cet égard, une démarche critique doit nécessairement s'interroger sur les notions qu'elle convoque et sur les critères qu'elles mobilise, ce qui implique de questionner le "numérique" par rapport au "digital" et au "computationnel", l'extension de l'écologie (ainsi que les notions de milieu, d'écosystème et d'évolution) à la réalité artificielle, et la notion d'impact elle-même dans la mesure où elle est à la fois ce qui relève d'abord du choc, de la perturbation, de la destruction d'un donné supposé stable et normal, comme ce qui exprime ensuite un impératif de mesure, d'évaluation, d'enregistrement de ce qui est nécessairement identifiable et calculable, et comme ce qui suppose enfin un possible contrôle sur les facteurs déterminant l'impact et une adaptation à ses effets.

C’est selon une telle approche multidimensionnelle, systémique et réflexive que le design pourrait ainsi aider à comprendre ce qu'implique le numérique dans l’ensemble du processus de connaissance et de transformation de la réalité, et contribuer au dépassement des alternatives classiques mentionnées plus haut comme au dépassement de l’opposition en design entre écologisme militant (design radical) et mensonge publicitaire ("green washing") qui polarise de manière stérile les positions au sein du domaine ainsi que les choix opérés dans de nombreux projets. À cet égard, le recours à l' "écodesign" développé par l’industrie depuis les années 1990 s’avère insuffisant voire trompeur, avant tout parce qu’il participe d’une gestion de la crise écologique plutôt que d’une remise en question des principes du modèle dominant - celui du techno-capitalisme extractiviste, carbonné, anthropocentré, computationnel et réticulaire - qui maintiennent les conditions de cette crise (exploitation de la nature, standardisation, opposition entre producteur et consommateur, perte de savoir, court-termisme, etc.) en l'imposant comme un état de fait, un ordre du monde irréversible, voire dans le pire des cas comme ce qui est souhaitable par dessus tout.

Être écologique pour le design à l'époque du numérique intégral, signifie donc dépasser l'écodesign, non seulement pour interroger les conditions matérielles (métaux, pétrole, énergie électrique, systèmes de transport, bâtiments) et les effets écologiques de l'infrastructure numérique (câbles, satellites, antennes, data centers, relais, serveurs locaux), des appareils (ordinateurs, smartphones, smartwatches, objets connectés), de leurs usages (volontaires et automatisés), et pour trouver des solutions de réduction des conséquences nocives de leur existence pour les milieux naturels et les milieux humains (sur le plan psychique, social, économique et politique). Mais c'est aussi un impératif d'imagination et d'expérimentation de nouvelles formes de conception, de production, de partage et de critique du numérique. Le design est capable d'assumer un tel impératif en prenant ses responsabilités, y compris en interrogeant sa propre dépendance au numérique. C'est précisément ce que ce projet éditorial cherche à montrer dans la diversité des points de vue, des pratiques de recherche et d'expression.

Un enjeu majeur s’impose alors comme horizon de ce projet éditorial : celui de la conception d’un monde "post-numérique". Faut-il vouloir, concevoir, produire, un monde "post-numérique" pour répondre aux enjeux écologiques? Le rôle du design est-il celui d’y contribuer comme il a pu contribuer au monde numérique actuel, c’est-à-dire aussi au modèle dominant de la modernité industrielle mondialisée devenu insoutenable? Venu du champ de l’art, le concept de "post-numérique" est récent et demeure aujourd’hui polémique tant il peut prendre des acceptions différentes et parfois contradictoires, surtout quand il s’applique au design.

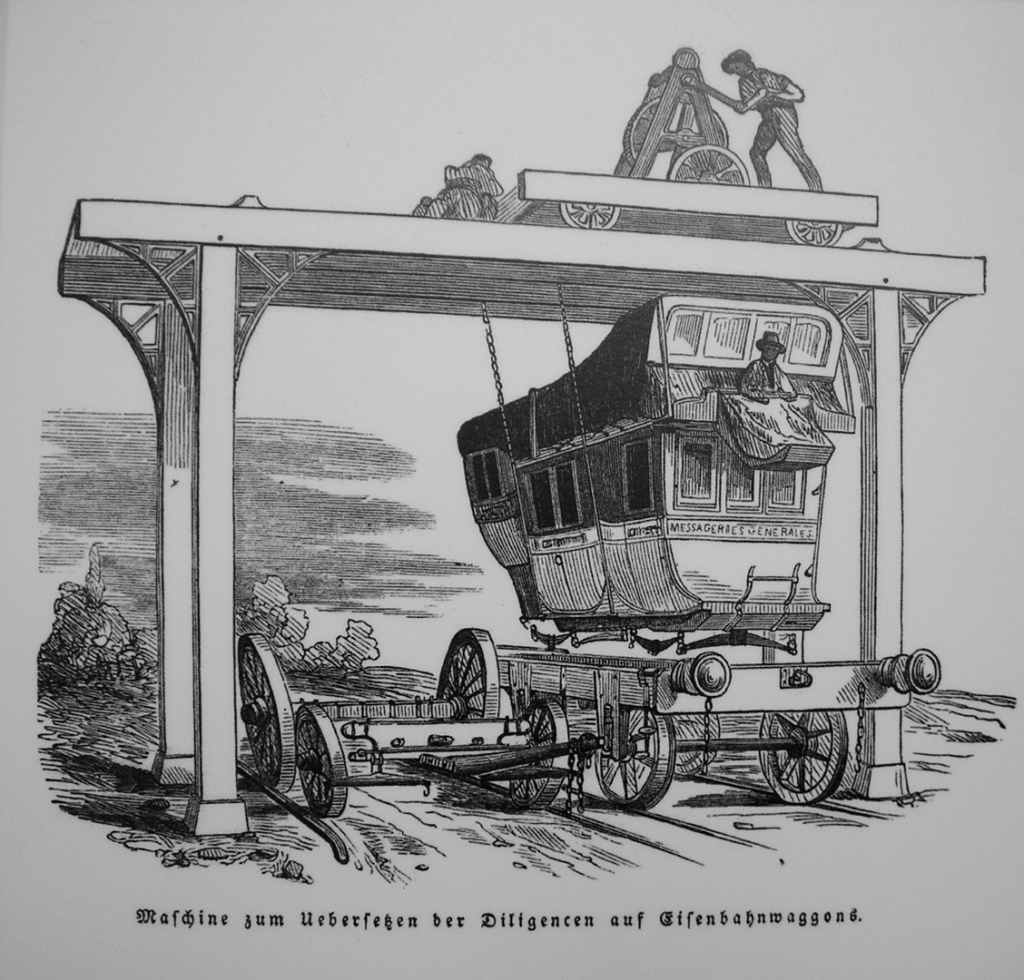

Premièrement, on peut évidemment entendre cette dénomination au sens chronologique et considérer qu’il s’agit d’une période postérieure à la constitution des techniques de conception, de production et de diffusion issues de la cybernétique, de l’informatique et de la télématique (on pense alors aux années 1980 plutôt qu’aux années 1950, et plus encore aux années 1990 avec le développement de l’informatique personnelle et surtout celle d’Internet à travers le web). Mais si une telle chronologie semble a priori commode, elle est en fait très problématique, en ce sens qu'elle assigne au numérique une origine unique et fixe sans tenir compte des décalages, des superpositions, des anachronismes, qui s'opèrent toujours au moment de l'apparition d'un nouveau système technique et plus encore dans le rythme de son adoption par la société où le rôle du design est déterminant (pour le diffuser, le faire accepter, le rendre facile à utiliser, voire pour l'imposer dans la culture).

Deuxièmement, on peut exprimer par là une position historique plus marquée et affirmer que le "post-numérique" désigne un autre design que le design analogique nécessitant la reconnaissance d’une césure historique qui dépasse la simple adoption de nouveaux outils dont les effets sont alors non seulement techniques et esthétiques, mais surtout ontologiques au point que le design change de nature. Une telle signification a une certaine pertinence dans la mesure où elle pose à juste titre que l'apparition d'un nouveau système technique peut transformer une pratique comme le design au point de la modifier dans tout ce qui la définissait par rapport aux autres pratiques existantes et apparentées, comme d'autres systèmes techniques et symboliques ont pu le faire dans le passé (l'écriture et l'imprimerie par exemple). Il serait toutefois tout aussi légitime d'affirmer que le design "post-numérique" conserve et/ou transpose des caractéristiques qui existaient auparavant et dont la trace est encore visible dans le design numérique actuel (tels le "bureau", les "outils", la "page", le "menu", pour ne parler que des plus évidents et des plus connus).

Troisièmement, on peut considérer que le design "post-numérique" est un design qui cherche à questionner le numérique en tant qu’ensemble ayant transformé la société dont l’omniprésence risque de dissimuler les enjeux éthiques, sociaux, politiques, et de manière plus préoccupante encore, les enjeux écologiques. Cette façon critique de l’envisager implique par exemple de remettre en question la place des écrans (attention, apprentissage, dépendance), le primat du "high tech" (complexité, fragilité, temps long et coût élevé de la R&D, ignorance du fonctionnement par les utilisateurs, alternatives "low tech"), l’impératif de l’automatisation (autonomie, décision, erreur), la soumission aux mégadonnées (calcul, contrôle, délégation), mais aussi et surtout de rétablir, réinvestir et renouveler la relation au monde physique, à la matérialité, à la vie, au corps, à l’humain, au-delà du code, du calcul, du programme. Si tous ces aspects du problème posé par le numérique intégral sont effectivement importants et même décisifs, il ne faudrait pas sous-estimer la capacité des géants technologiques et économiques (GAFAM) à intégrer ces critiques comme des opportunités de redéploiement de leurs activités et de maximisation des profits, comme le corps-interface dans les activités vidéoludiques (par les capteurs de mouvement et l'appropriation corrélative des gestes par brevet) ou la bulle spéculative autour de la signature cryptée des NFT ont pu le montrer ces dernières années, ou comme on peut le constater plus profondément dans la transformation structurelle de la matière (nanoingénieurie) et de la vie (biotechnologies) dirigée par la technoscience (NBIC).

Quatrièmement, ce questionnement peut se faire plus critique encore et devenir radicalement politique en appelant "post-numérique", un design qui refuse de passer par le numérique, donc qui refuse de mobiliser des techniques, des machines, des ressources matérielles et des sources d’énergie, mais aussi des modes de représentation, des modes de socialisation et d’organisation collective, considérées comme étant propres au "numérique" et produisant une dégradation des milieux de vie et des humains qui leur donnent sens. Le recours au "pré-numérique" peut alors apparaître comme une solution de repli séduisante, mais comportant le risque d’un retour illusoire à une situation définitivement passée qui reste malgré tout déterminée, même indirectement, par le numérique. Une archéologie du numérique (par l'archéologie des médias par exemple) montrerait par ailleurs assez facilement : d’une part l’existence de liens quasi indéfectibles du numérique avec l’analogique (histoire de l’écriture, du code, du calcul, de la tabulation, de la transmission d’information, etc.) et en particulier avec des techniques vernaculaires artisanales (comme le tissage, la broderie, etc.), et d’autre part la nécessité pour toute invention d’intégrer les schèmes, les méthodes et les formes du passé pour se constituer et s’inscrire dans la culture. Ce à quoi il faudrait évidemment ajouter la dépendance directe du numérique au système analogique, ne serait-ce que celle qui l'unit au système de production d'énergie électrique (ce dernier étant cependant de plus en plus piloté par le numérique).

Sans prendre parti pour telle ou telle signification de l’expression "post-numérique" et de lui associer une idéologie, un courant intellectuel ou une esthétique, cet enjeu traverse, même implicitement, la plupart des contributions de ce projet éditorial. Et si elles n’investissent pas cette question de front, elles proposent en tout cas de réfléchir à une conception écologique pour "refaire un monde" soutenable et partageable selon des formes inédites de représentation, de production, d’édition et de narration qui intègrent le numérique comme questionnement sur les principes, les conditions et les effets de la pratique du design. Le paradoxe est alors que le "post-numérique" comme horizon possible des contributions n’en exclut pas pour autant l’intérêt du numérique, à condition de le considérer ni comme la cause unique de la crise écologique ni comme sa solution incontournable ni non plus comme un outil neutre et sans conséquences, mais comme un dispositif expérimental fait de tensions, de frictions, de traductions et de potentiels dont on ne peut pas ignorer la puissance constructrice et destructrice (c'est-à-dire "pharmacologique", à la fois "poison" et "remède" exigeant une thérapeutique).

Dans ce projet éditorial, il en va donc non seulement de ce que le numérique fait au design mais surtout de ce que le design peut faire du numérique et au numérique pour qu’il puisse être enfin moins destructeur pour la nature comme pour l’esprit, pour les artefacts comme pour les milieux sans lesquels il n’y pas de création ni de vie possibles. C'est précisément dans cet esprit que les contributions réunies ici entendent apporter des éléments pour comprendre les enjeux pour le design actuel d'une postérité numérique qui ne soit pas l'aggravation de la catastrophe, la poursuite aveugle de l'innovation permanente et l'adhésion béate à la "smartness" des AI, mais le soin à long terme de l'alliance vertueuse de la vie organique, de la vie technique et de la vie symbolique, celle qui fait du monde humain un monde partageable et habitable au moment où la biosphère tend à se confondre avec la technosphère et où l'humanité est tentée par un avenir post-politique et trans-humain délétère.

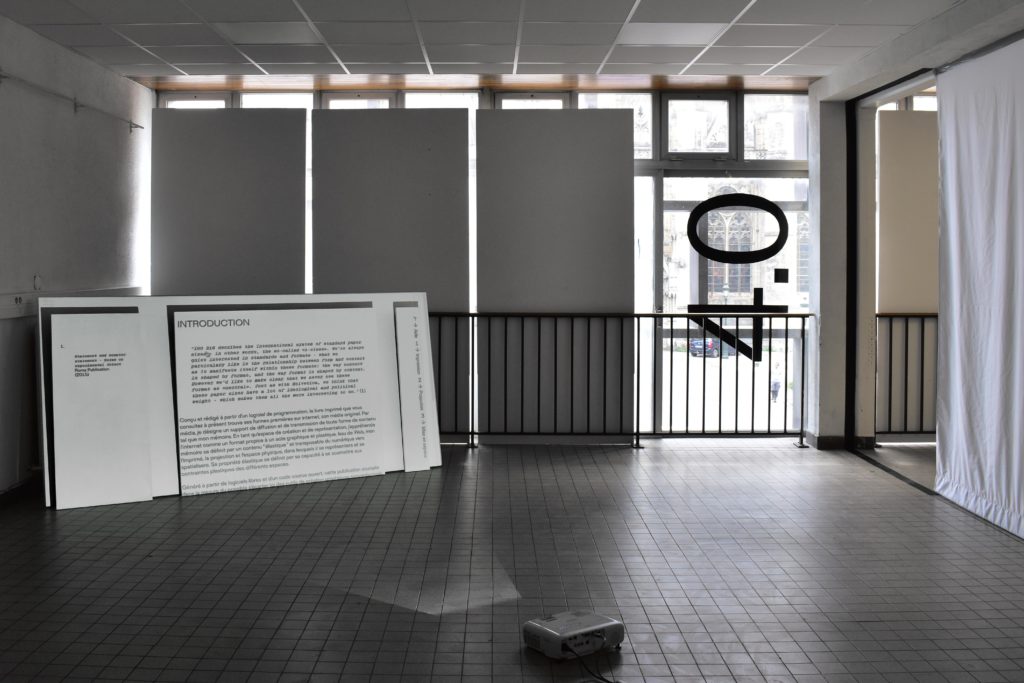

Ce projet éditorial témoigne des recherches de l'unité de recherche ECOLAB au sein de l’École Supérieure d’Art et de Design d’Orléans entre 2017 et 2019. Il constitue les actes augmentés de deux colloques dont le premier volet "Les écologies du numérique" (9 et 10 Novembre 2017) avait pour principale ambition de questionner les formes d’écologie que le design pouvait à la fois questionner, concevoir et transformer pour comprendre les enjeux actuels du numérique. Le second volet, intitulé "Les écologies du numérique #2 Vers un design post-numérique?" (13 et 14 Décembre 2018) proposait pour sa part d’interroger la possibilité et la pertinence d’un design "post-numérique" à travers deux thématiques : "matérialités post-numériques et savoirs vernaculaires" et "design éditorial et nouvelles formes de narration".

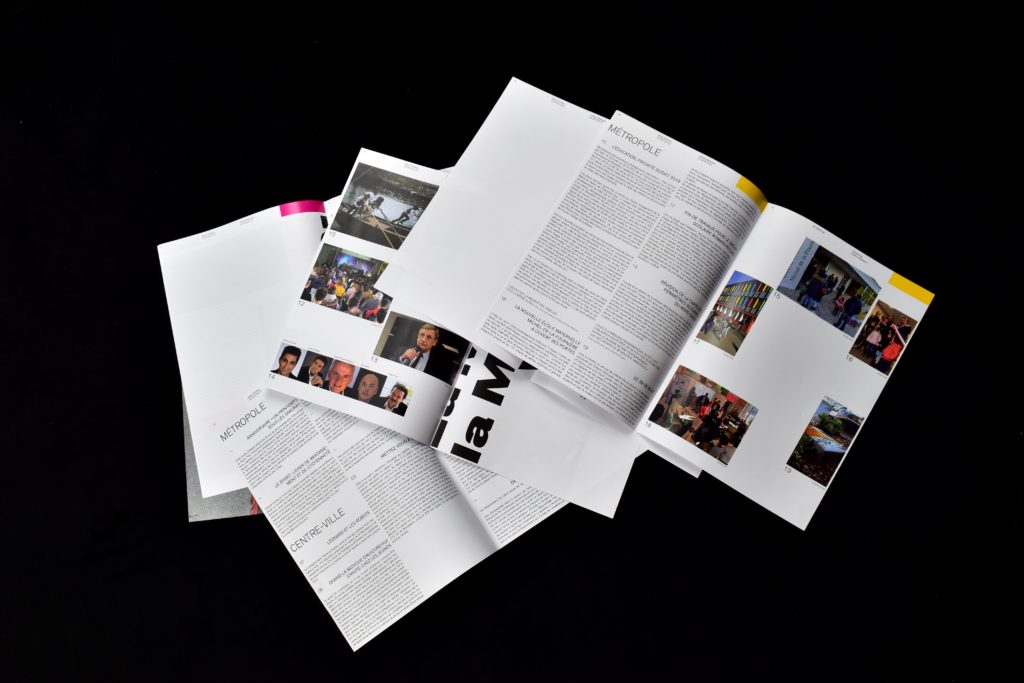

Par le choix d'un contenu proposé intégralement en ligne sous la forme d'un site web to print, il fallait en quelque sorte prendre acte d’une nouvelle économie de l’édition, en particulier de l’édition d’ouvrages collectifs proposant un contenu théorique (à la fois peu écologiques même avec un papier certifié, des encres végétales et des circuits courts d'impression ; coûteux à produire, surtout aujourd'hui avec la crise durable du papier ; difficiles à diffuser à cause du prix de vente et du contenu très spécialisé), mais aussi et surtout d’une nouvelle écologie du savoir directement engendrée par les nouvelles formes d’écriture, de lecture et de diffusion que le numérique rend possible. Il serait donc erroné de voir là un aveu d’échec quant au combat pour la circulation des idées dans la société actuelle ou un geste purement pragmatique d’adaptation au marché de l’édition classique bouleversé par le numérique (notamment par l’autocomplétion de l’écriture, l’automatisation de la lecture, l’algorithmisation de la narration, et plus encore par l’automédiatisation et l’autoédition). Il s’agit donc d’un véritable parti pris pour les idées, pour la pensée, pour la publicité du savoir dans une époque où s’imposent la numérisation massive du savoir publié, l’industrie des plateformes de contenu, la logique de l’audience et d’exploitation de l’attention, l’appropriation économique des langues, l’automatisation de la pensée et de la conversation, auxquelles tentent de résister le hacking, la conception de logiciels libres, les plateformes collaboratives et les communautés d’amateurs.

Partant de cette idée et participant de cet engagement, les contributions présentes dans ce projet éditorial sont toutes animées par l’impératif d’établir un nouveau rapport au savoir, à ses conditions de production et à sa publicité, en étant à la juste mesure des transformations produites par la numérisation. Cela se traduit dans le choix de proposer un ensemble de contributions qui soient des réécritures des interventions aux deux colloques, au double sens d’une écriture seconde qui approfondit et prolonge ce qui a été dit, et d’une nouvelle écriture qui en diffère complètement par le nouveau contexte de diffusion. D’autres contributions inédites (Yves Citton, Fabrice Flipo, Jean-Jacques Gay, Roxane Jubert, Andrew Feenberg) viennent aussi s’ajouter à l’ensemble initial en apportant un complément nécessaire, en déplaçant un point apparemment assuré, en ouvrant une perspective inattendue, pour faire de cette publication un objet non linéaire dans sa structure et non univoque dans son propos.

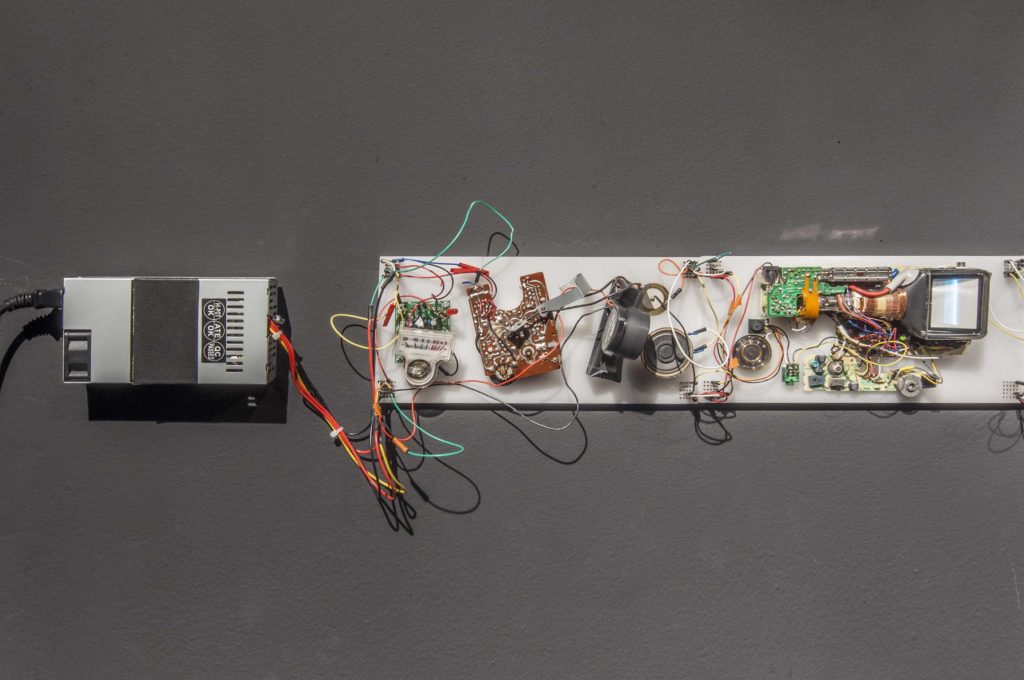

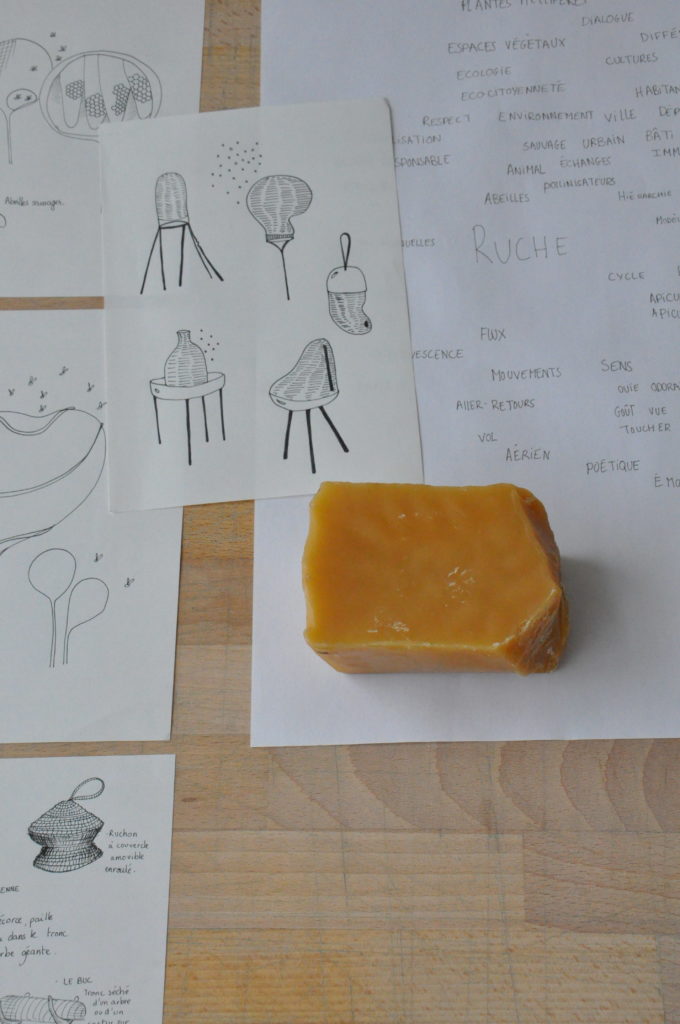

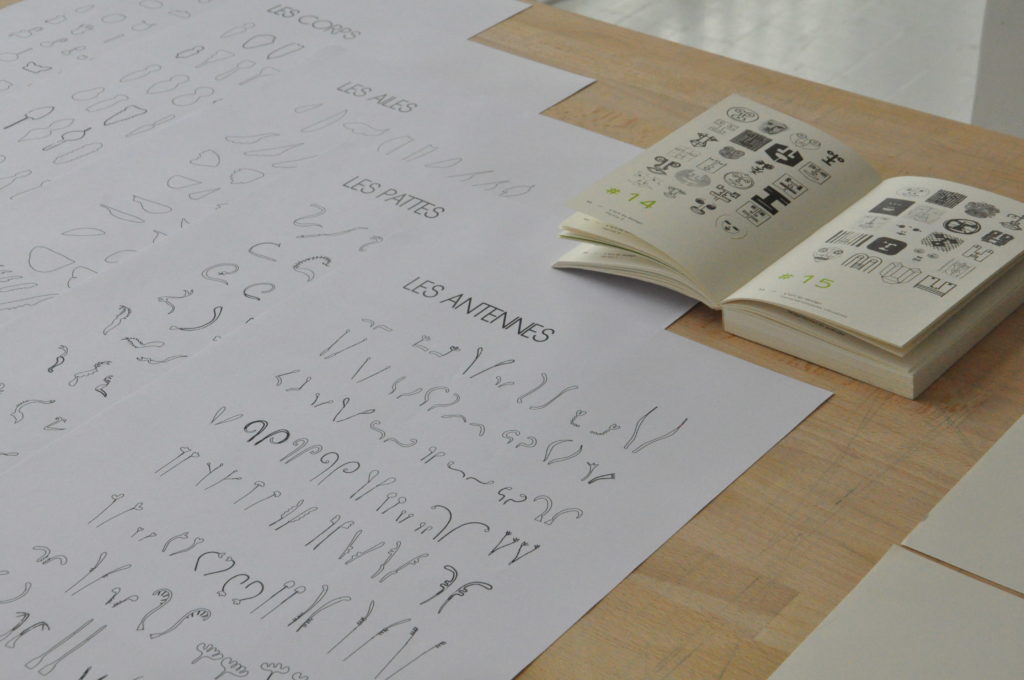

Les présentations de projets de création jouent à cet égard un rôle décisif qui n’est pas du tout celui d’une illustration des textes théoriques : leur rôle est à la fois celui d’une articulation entre les textes par le hors texte (celui de l’image), à la manière d’une trame rythmique et d’une pensée qui s’écrit autrement dans un réel dialogue, et celui d’un contrepoint sensible et autonome qui déborde les textes en traçant des lignes marginales à partir de ce que les textes ne peuvent pas dire. Une sélection de projets de Master d’ancien·ne·s étudiant·e·s de l’ÉSAD Orléans vient enfin marquer la synergie entre recherche et pédagogie, entre enseignement et création, entre ce qui est transmis dans une école et ce qui ne peut pas l’être autrement que par l’expérimentation.

La construction d’un tel projet éditorial s’est donc faite sans hiérarchie entre les différentes contributions, dans l’esprit de la recherche produite dans les écoles d’art et de design qui se fait aussi bien par les chercheuses et chercheurs du monde académique, par les actrices et acteurs du monde de la création, que par les étudiantes et étudiants en 2e et 3e cycle. C’est ce qui fait de ce site web (réalisé via Wordpress) un premier engagement dans une recherche contributive décloisonnant les types de savoirs, de disciplines, de supports, de pratiques, de statuts, en cohérence avec le potentiel du numérique et la nécessité écologique de transformer toutes nos habitudes de penser, de vivre et d’agir. C’est justement là le rôle des structures d’enseignement, en particulier celui des structures publiques d’enseignement supérieur "artistique", de cultiver le goût pour le savoir mais aussi le désir de s’émanciper des réalités instituées pour ouvrir d’autres voies à l’esprit du temps et à l'avenir du monde.

Nota bene : les textes présentés dans cette publication ont été écrits à des dates différentes en raison de leur rédaction initiale pour une communication lors du colloque "Les écologies du numérique" (en 2017 et en 2018), puis de leur actualisation en vue de la publication des actes (2019 et 2020), et d'autres textes ont été écrits postérieurement en raison d'invitations adressées à des chercheuses et chercheurs (en 2020) pour compléter les contributions et offrir ainsi des "actes augmentés".

—

Résumé

Comment faire des livres dans l’ère post-numérique? Pour répondre à cette question décisive aujourd’hui, cet article propose de revenir sur différentes modalités d’édition en interrogeant supports et conditions, moyens et échelles. Mais c’est la question du droit d’auteur, restée jusque-là dans l’obscurité, dont l’impact est examiné comme atteinte à la liberté de création dans un contexte où les pratiques éditoriales sont de plus en plus menacées par le contrôle algorithmique. Des outils sont proposés ici pour tenter de lutter contre une situation délétère pour la création au profit d’une pratique « libre » qui réclame le droit de copier et cherche à faire évoluer la législation.

Texte écrit en 2020 pour les actes du colloque « Les écologies du numérique » organisé par l’Ésad Orléans (ÉCOLAB) en 2017 et 2018.

—

Mots clé

Post-Numérique, droit d’auteur, copier, publier, législation, libre

—

Biographie

Eric SCHRIJVER

Auteur et designer d’interaction, Eric Schrjiver est né à Amsterdam et vit et travaille à Bruxelles. En tant que designer, il travaille notamment sur des interfaces d’édition et des publications numériques et hybrides. De 2011 à 2017, il a fait partie du noyau du collectif graphique Open Source Publishing. À travers son blog I like tight ponts and mathematics, il sensibilise les designers et artistes à des questions culturelles liées à la programmation informatique. En 2018, il a publié son premier livre Copy This Book. An Artist’s Guide to Copyright (Onomatopée, Pays-Bas). Ce guide à la fois critique et pragmatique aide des créatif·ve·s à naviguer dans les paradoxes du droit d’auteur.

Dans les années 1990, en suivant un tutoriel édité par le mythique fournisseur d’Internet amstellodamois XS4ALL, j’ai réussi a faire apparaître sur le web les mots « HELLO WORLD ». Peu de choses de ma pratique numérique d’adolescent font encore partie aujourd’hui de ma vie, mais l’édition numérique, surtout en ligne, ne m’a pas quitté depuis. En 2008, quand j’ai commencé à enseigner le design d’interaction aux étudiant·e·s de l’École des Beaux-Arts de La Haye (la KABK), j’étais plongé dans différentes sous-cultures du numérique : le design web d’un côté, mais aussi la communauté du logiciel libre qui cherchait de nouvelles méthodes de collaboration en ligne. Toutes ces personnes avaient l’habitude de publier leurs projets sur des sites et des blogs, et de cette manière j’ai pu être au courant de leur travail et parfois collaborer avec des gens de l’autre côté du monde[1]. Le design et l’édition numérique se montraient très accessibles, et il me semblait facile d’y intervenir et d’avoir un impact sur ce qui était et qui reste encore un champ en pleine mutation et expansion. Bien plus facilement en tout cas que dans des pratiques plus établies, saturées et intimidantes comme le design de livres papier et d’affiches.

Lorsque j’ai commencé à enseigner, j’ai donc été un peu surpris de découvrir que mes étudiant·e·s (et certain·e·s de mes collègues) se montraient souvent beaucoup plus enthousiastes pour des supports graphiques comme les posters et les livres papier, et qu’iels ne ressentaient pas la même excitation à investir des formats édités et partagés sur écrans. Même dans des écoles très pluridisciplinaires, peu importe le sujet, mes étudiant·e·s revenaient presque systématiquement vers moi avec des éditions papier.

Cet intérêt pour des formes analogues et au long pedigree ne se limite pas aux écoles, comme en témoigne une tendance mondiale à organiser des « book fairs », dont le nombre a explosé dans les dix dernières années[2], et cette tendance ne se limite pas non plus au livre, mais inclut plusieurs médiums « zombies », dont l’obsolescence semblait programmée, mais qui reviennent en force, comme les magazines xérographiés, l’impression riso et les cassettes audio.

La volonté d’éditer sur des supports physiques ne me semble pourtant pas liée à un refus des technologies numériques : le plupart des designers et artistes qui font des éditions aujourd’hui s’emparent d’ordinateurs et de logiciels. Ce n’est donc pas au sein du processus créatif que l’attraction se trouve, mais dans les modalités de distribution. Dans ce qui suit, je passerai en revue différentes modalités d’édition à l’heure post-numérique, en interrogeant supports et conditions, moyens et échelles. Je pourchasserai quelques zombies, en déterrant leurs racines profondes. Une d’entre elles, jusque-là restée dans l’obscurité : le droit d’auteur, dont j’examinerai l’impact, cette fois pas comme un vecteur d’émancipation des artistes mais plutôt comme une atteinte à la liberté de création, ayant une influence sur nos processus créatifs, incluant nos choix de médiums. Je mettrai en lumière la façon dont les changements législatifs amenés par la récente directive européenne impacteront les pratiques éditoriales avec l’évolution probable vers un contrôle algorithmique. Je tenterai enfin de fournir des outils pour se défendre contre ce qui s’avère pire que les zombies de l’analogique…

L’arrivée du numérique n’a pas rendu obsolète les médiums physiques, mais leur rôle et leur statut s’est transformé et continue à muter en relation avec de nouveaux objets dans le paysage de la publication désormais hybride. Dans Post-Digital Print, La mutation de l’édition depuis 1894[3], Alessandro Ludovico décrit les changements dans l’édition qui ont mené à un écosystème dans lequel les chaînes de production des supports physiques et analogiques sont entrelacés. Dans cet écosystème, le médium du livre imprimé a pu maintenir une position importante pour plusieurs raisons. D’abord, c’est une interface de lecture ergonomique, entre autre parce qu’il permet le feuilletage. Ensuite, là où beaucoup de systèmes d’édition numérique manquent en flexibilité pour varier leurs feuilles de style en fonction du contenu, le livre permet de faire un design cohérent entre forme et contenu, couverture et intérieur. Il contient sa propre représentation, par sa couverture, ce qui aide à se faire représenter et à s’imprimer dans la conscience collective. Et même si la majorité des expériences de lecture se fait aujourd’hui sur des écrans, ces éditions sont souvent fragiles. Elles dépendent d’un hébergement à maintenir, parfois d’abonnements qui peuvent être résiliés, et sont inscrites dans un réseau de liens qui peuvent à tout temps arrêter de fonctionner. Parce que le livre physique est contenu en lui-même[4] et que les infrastructures autour du livre existent depuis longtemps, il existe non seulement des magasins pour les vendre mais aussi des bibliothèques pour les prêter et les archiver. Finalement, le livre papier est aussi un moyen indispensable pour légitimer son contenu. Parce qu’il reste encore aujourd’hui peu accessible de publier un livre – il demande un certain nombre de moyens, notamment économiques, mais aussi de trouver sa place dans une chaîne relativement restrictive – on a tendance à légitimer les contenus et la parole d’auteur·e·s qui ont eu l’opportunité d’en publier[5]. Moi-même, ayant récemment publié mon premier livre en papier, j’ai pu faire l’expérience de la transformation, en tout cas symbolique, d’avoir publié un « vrai » livre. Et pourtant je publiais depuis longtemps en ligne.

Si l’attrait pour le livre reste donc compréhensible, cela ne veut pas forcément dire qu’un format imprimé est le meilleur format pour tout projet d’édition. Dans le monde post-numérique, certaines formes imprimées prospèrent et certaines sont marginalisées – comme en témoignent les annuaires téléphoniques et les encyclopédies, aujourd’hui principalement consultés en ligne. Dans le contexte de l’édition culturelle et artistique également, certaines formes imprimées bénéficient plus que les autres du remaniement effectué par l’arrivée du numérique. En tant qu’artiste, avoir un site internet et apparaître sur des blogs est une chose, mais un catalogue monographique reste inégalable pour se démarquer dans le marché de l’art. Même les graphistes les plus référencé·e·s de l’époque du premier « boom » du web, et qui traitaient de l’influence du numérique dans leur travail, se sont légitimé·e·s par des magazines imprimés (par exemple Emigre). C’est certainement à cette ironie que David Carson faisait référence en nommant sa monographie en papier The End of Print en 1995[6].

Au-dessous d’une certaine quantité de pages, par contre, beaucoup d’avantages du livre peuvent disparaître. Une raison toute bête, c’est qu’il devient alors impossible pour l’édition d’avoir un dos, et une grand partie de l’écosystème du livre dépend de son dos. Le dispositif principal pour présenter et ranger des livres, de la librairie à la bibliothèque de prêt et aux espaces privés, est la bibliothèque, dans laquelle les livres sont en majorité rangés « en montrant leur dos », qui contient des informations qui les rendent identifiables. C’est un des grands défis qu’amènent les zines, par exemple. Il est compliqué de les vendre dans un réseau de distribution en librairie[7], non seulement pour leur fréquente absence d’ISBN mais aussi pour leur format « sans dos ». Et une fois vendus, d’expérience, ils sont plus vite oubliés (car moins visibles), et ils survivent moins bien au tri, car on se débarrasse plus facilement des livres qui sont compliqués à ranger dans sa bibliothèque. Dans les bibliothèques publiques et les archives, ces publications sont classées comme « ephemera », et toutes les institutions n’ont pas forcément l’infrastructure pour les gérer.

De plus, pour qu’un contenu fonctionne en tant que livre, il faut aussi qu’il soit diffusé en un certain nombre d’exemplaires. L’objet pourra alors être diffusé dans un cercle moins restreint que le cercle social de son édit·eur·rice, en passant par exemple par une structure de diffusion. En plus, à partir d’environ 500 exemplaires, il devient possible de travailler en impression offset, ce qui donne une grande flexibilité au niveau des choix d’encres et de papier, mais aussi de travailler avec des imprimeu·r·se·s qui amènent leur expertise au projet, et avec des processus industriels amenant précision et rapidité. Je comprends qu’il ne soit pas nécessaire pour chaque projet de trouver les moyens d’investir dans une édition en offset. Il y aussi beaucoup de projets qui veulent travailler avec des contenus plus succincts. Mais c’est exactement là où, avant de se tourner vers une édition limitée en papier, je me demande toujours : – pourquoi pas une édition numérique ? L’édition sur écran offre des possibilités importantes : elle est moins chère, plus rapide, et capable de toute une série de solutions graphiques inaccessibles aux formats physiques : l’inclusion d’animation, de son, de vidéo ; la contextualisation par hyperlien, et l’ajout des interactions programmées. Avec en plus la possibilité pour les contenus de circuler à une échelle mondiale sans dépendre de services postaux.

Aujourd’hui, beaucoup de graphistes, édit·eur·rice·s et artistes créent des éditions numériques[8]. Et en même temps, il y a également une tendance à créer des petites éditions d’objets physiques. Je reviendrai sur cette question des éditions limitées. La dimension « micro » est tout à fait assumée par les créat·eur·rices qui la pratiquent, comme en témoigne l’utilisation du le terme « micro-édition » pour désigner des objets, des événements et des structures éditoriales. La notion de petite échelle dans l’édition est une catégorie à part entière. Cette tendance me semble intéressante à rapprocher du mouvement des « micro-brasseries », qui nomme la tendance à créer des bières à petite échelle avec des méthodes artisanales. Mais il y a une différence fondamentale entre faire de la bière et faire des œuvres d’esprit. Dans le cas des bières, produire à une échelle industrielle demande des fonds importants, alors que la particularité de l’édition numérique, c’est qu’elle permet une grande flexibilité d’échelle, avec des moyens réduits au minimum. Pourquoi donc cette insistance sur les productions à petite échelle?

Une autre tendance que j’ai pu remarquer, au-delà du choix de faire de la « petite édition », autre terme utilisé dans le champ, c’est le recours à des techniques de reproduction oubliées par le mainstream. On pourrait par exemple se pencher sur la forme du fanzine, qu’on trouve de plus en plus sur les tables des foires de livres d’artistes. Les fanzines, c’est d’abord un phénomène historique. Les fans de science fiction ont trouvé ce moyen pour échanger à propos de leur passion (à noter qu’il n’existait alors pas de revues qui représentaient ce qui était classé comme sous-littérature à l’époque), puis ce fut le tour des punks et des Riot Grrrls, entre autres mouvements contestataires. Aujourd’hui, ce n’est pas comme si les fans de science-fiction ne discutaient plus, n’écrivaient plus et n’exprimaient plus leur créativité. Sauf qu’iels n’ont plus vraiment besoin d’une photocopieuse pour cela. Iels se sont appropriés les forums, les blogs, les réseaux sociaux… Les artistes, commissaires d’exposition et graphistes qui choisissent aujourd’hui de s’approprier les formes du fanzine peuvent profiter d’un héritage culturel important (et espèrent peut-être profiter un peu de son aura!) mais en choisissant ces formes, iels se retrouvent un peu le « cul entre deux chaises », ne pouvant ou ne voulant pas forcément profiter des réseaux informels de distribution qui se sont historiquement construits autour des zines, ni des possibilités des formats numériques.

Comment expliquer le fait qu’une photocopieuse à encre liquide – largement oubliée depuis que la combinaison imprimante laser, scanner et photocopieuse numérique a conquis les bureaux – gagne une grande renommée chez les graphistes? Je parle du risographe bien sûr, qui dans cette dernière décennie a vécu une renaissance spectaculaire. En fait, avec la risographie, je peux encore comprendre en partie son intérêt. Tout comme les photocopieuses et les imprimantes laser, qui forment la base de la technologie « print on demand », la riso permet de faire des reproductions papier en petite édition et demande donc moins de moyens économiques à investir. L’avantage c’est que la riso permet l’utilisation de couleurs éclatantes qui sont normalement réservées à l’impression offset, économiquement viable qu’à partir d’un nombre d’exemplaires élevé, ou encore la sérigraphie, qui demande un processus de préparation long et un matériel plus complexe.

De tous les médiums que j’ai vu renaître dans ce monde post-numérique, celui qui m’as le plus surpris n’est pas en papier : il s’agit du regain d’intérêt actuel pour l’édition en cassette audio. Le journal néerlandais NRC a publié un entretien avec deux habitants de la région d’Eindhoven. D’un côté un ancien ingénieur nonagénaire de chez Philips, de l’autre un jeune entrepreneur ayant racheté une fabrique d’audio-cassettes[9]. L’ingénieur, qui était à la base du développement de l’audio-cassette quand il avait l’âge de l’autre, a ensuite rejoint l’équipe qui a développé le compact disc. Il ne comprend rien à cette nouvelle génération qui veut utiliser un médium de mauvaise qualité sonore. Écrire un CD, ça coute moins qu’une audio-cassette, et surtout, aujourd’hui, la bande passante d’internet est bien assez puissante pour qu’on puisse distribuer sans investissement préalable des morceaux de qualité CD ou même supérieure. D’où vient donc le choix de distribuer son travail sur cassette ?

Avant, j’avais des explications peu flatteuses pour justifier le désir des artistes et graphistes de disséminer sur des supports physiques (démodés en plus!), en édition limitée. Je pensais surtout qu’iels étaient soit nostalgiques et soit élitistes. Mais aujourd’hui je ne suis plus tout à fait d’accord avec cela. J’ai trouvé une réponse plus sympathique. Je pense qu’iels ont aussi compris que le support physique leur permet l’accès à quelque chose d’autre : la liberté de création.

Dans le contexte de l’Europe occidentale, un des vecteurs majeurs pour restreindre la liberté de création est le droit d’auteur. Ce n’est pas forcément évident, mais le droit d’auteur peut en réalité se montrer très contraignant pour la création, alors qu’il est souvent présenté comme étant censé la défendre. Malgré le fait que les techniques comme la citation, la parodie, le sampling, le remix et le détournement sont devenues très courantes comme stratégies artistiques (même si elles ont toujours fait partie de la création), les lois et la jurisprudence sont devenues plus strictes. Si à ses débuts au 18e siècle le droit d’auteur se concentrait sur la copie d’un contenu tel quel (notamment des livres), le droit d’auteur a évolué vers un modèle où n’importe quelle adaptation est une infraction. Oui, il y a la liberté de citation, mais cette liberté n’est clairement développée que pour le texte, pas pour l’image.

Le fait que le droit d’auteur ait un impact sur la création n’est pas du tout une évidence, ni pour les créati·f·ve·s, ni pour les politicien·ne·s, ni pour les juristes. Dans la rhétorique du droit d’auteur, ce dernier est censé protéger l’auteur·e. Et c’est vrai : le droit d’auteur donne aux créatifs la possibilité d’exploiter et de contrôler une partie de sa production. Il est par exemple indispensable dans les négociations avec des éditeurs et autre diffuseu·r·se·s. Mais il contraint aussi sa création.

L’histoire de la musique contemporaine nous en montre un exemple simple. Quand la technique du « sampling » est devenue populaire dans les années 1980, il n’y avait pas encore de pratique légale pour la contester. C’est pour cela que les artistes de l’époque ont pu incorporer des fragments de nombreux morceaux pour les détourner de façon créative. En écoutant aujourd’hui des morceaux de De La Soul ou des Beastie Boys, il est surprenant de remarquer à quel point ils ont été capables de réutiliser ou citer des morceaux très connus – souvent même en faisant du sampling de plusieurs morceaux sur une piste. C’était une période où les ayant droits n’avaient pas encore commencé à revendiquer leurs droits, et personne alors ne savait si le droit d’auteur allait incorporer une possibilité de sampling. Les choses ont bien changé ensuite. Au fur et à mesure des procès contre le sampling, la jurisprudence a basculé vers une situation où n’importe quel sample, même très court, doit faire l’objet d’une licence. Aujourd’hui, le sample a disparu du vocabulaire, sauf pour le sampling « bling bling ». Le sample est devenu comme la Bentley dans les clips: quand Kanye sample Daft Punk, on sait que cela lui a coûté cher.

Cette situation ne concerne pas uniquement la musique. Les artistes plasticien·ne·s et les graphistes se retrouvent aussi restreint·e·s par le droit d’auteur. Voici une liste non-exhaustive de choses qui sont empêchées par le droit d’auteur :

– utiliser n’importe quelle image sans demander la permission à son auteur·e – même si on ne sait pas qui est l’auteur·e (une « image orpheline »)

– faire un dessin ou une peinture basée sur une photographie

– faire un détournement critique et/ou artistique d’une image existante sans humour (la moquerie est importante pour que cela soit considéré comme une parodie – une des rares exceptions au droit d’auteur)

– faire une photographie en studio où sont utilisés du mobilier, des vêtements ou des bijoux, sans permission[10]

Certaines de ces pratiques qui constituent des infractions au droit d’auteur semblent pourtant très courantes dans le travail créatif. Et une partie du problème est là. Le droit d’auteur est à la fois très strict, très souvent enfreint et peu mis en pratique. Le droit d’auteur fait partie du droit civil, et lorsqu’une reproduction enfreint les droits d’auteurs d’une personne, légale ou physique, il faut qu’elle-même montre un intérêt actif à empêcher ou à négocier cette reproduction. Pour cela, il faut d’abord qu’elle repère l’infraction à ses droits d’auteurs. Ensuite, c’est à elle de décider si elle veut contacter la personne qui a copié son travail pour négocier les conditions de cette utilisation ou l’interdire. Si ces deux personnes ne trouvent pas d’accord, la personne copiée, si elle en a les moyens, peut faire un procès à la personne l’ayant copiée. Pour qu’une infraction devienne un problème, il faut donc que l’ayant droit soit au courant de cette infraction et veuille agir. Il n’y a pour l’instant pas de processus magique permettant aux ayants droit de constater des copies d’un travail. Tout cela dépend beaucoup des rencontres faites par hasard, et aussi du fait que plus une œuvre circule, plus elle risque de croiser le regard des ayant-droits.

Il me semble que les risques légaux de la création artistique contemporaine font partie des raisons pour lequelles les créati·f·ve·s choisissent de travailler dans des éditions physiques et limitées. Tout le monde n’est pas au courant des détails du droit d’auteur, mais les gens en savent assez pour que les personnes qui pratiquent des stratégies artistiques courantes, comme la citation visuelle, se disent que cela pourrait représenter un risque. Et il me semble que, consciemment ou inconsciemment, on cherche des stratégies pour réduire ce risque.

Je crois qu’aujourd’hui beaucoup de créati·f·ves suivent une stratégie qu’on peut appeler la « Sécurité par l’Obscurité ». C’est une terme utilisé par les ingénieur·e·s du domaine de la sécurité informatique pour désigner les stratégies qui dépendent que certaines informations restent en sous du radar. Il ne s’agit pas d’éviter l’infraction au droit d’auteur, mais de minimiser les chances que son infraction soit repérée. Avec des éditions graphiques sur papier, on a l’avantage d’utiliser un médium qui permet de faire circuler un contenu dans un cercle restreint. Dès que l’on publie en ligne, si un contenu devient « viral » il peut se retrouver tout d’un coup partagé à une échelle énorme. Si on publie sur papier, ou sur cassette, ce risque est moins probable. On maîtrise donc mieux la dissémination[11].

Un projet d’édition numérique demande une stratégie différente, où on essaie non pas de minimiser les chances de découverte des infractions, mais de minimiser les infractions elles-mêmes. Ce type de stratégie demande une certaine connaissance du droit, une compétence qui ne fait pas forcément partie des outils acquis lors des études artistiques, et qui n’est pas non plus activée ni valorisée par la suite… C’est peut-être pour cette raison que les premiers projets d’édition numérique dans lesquels je me suis retrouvé, étaient soit faits par des grandes maisons d’édition, soit par des gens intéressés par le monde du logiciel libre et des Creative Commons. Ces maisons d’édition de grandes tailles peuvent investir dans des conseils légaux et/ou payer pour des licences. Et pour les passionné·e·s du libre, il est plus habituel que pour les autres créateur·e·s d’avoir une connaissance du droit d’auteur et une volonté idéologique que des éléments adaptés ou réutilisés soient eux-mêmes sous licence libre ou dans le domaine public. C’est cet accès aux ressources légales qui fait que ces act·eu·rices se sentent plus sûr·e·s dans leur démarche d’édition numérique.

Une alternative à la sécurité par l’obscurité peut donc passer par l’acquisition des connaissances juridiques d’un côté, et de l’autre par la volonté de trouver d’autres stratégies créatives. La nécessité de ne pas uniquement compter sur l’obscurité va devenir de plus en plus importante, notamment à cause des nouvelles législations liées à la directive européenne récente sur le droit d’auteur dans le marché unique. La directive ayant été votée en mars 2019, les états membres ont jusqu’à mars 2021 pour la concrétiser dans des lois nationales. Si la majorité du droit d’auteur va rester telle qu’elle est déjà, il va quand même être appliqué de façon beaucoup plus massive. Avec l’application de ces nouvelles lois, le droit d’auteur va se transformer d’un droit activé par l’initiative des personnes impliquées vers une règle appliquée de façon algorithmique.

Malgré ses bonnes intentions de base, celles de vouloir mettre au même niveau les différents législations nationales et d’uniformiser la gestion du droit d’auteur entre différents supports, l’Union Européenne semble avoir raté plusieurs occasions importantes autour de la directive. Il me semble que les législateur·e·s auraient pu essayer de régler au moins une partie des problèmes que le droit d’auteur pose actuellement avant d’agrandir sa portée. Par exemple, il existe aujourd’hui des différences importantes entre les états membres de l’U.E. dans la façon dont ils implémentent les exceptions du droit d’auteur. La citation audiovisuelle est par exemple gérée différemment partout, ce qui fait qu’en France, la citation d’une image pose plus de problèmes qu’en Belgique[12]. Dans les lois Européennes, il manque un équivalent au statut de « fair use » comme ont pu l’établir les États-Unis. Ce statut permet une copie non-consentie par les ayants droit sous certaines conditions : en prenant en compte le nombre de copies, le contexte de la reproduction (par exemple dans un contexte pédagogique), si et comment l’original a été transformé et si la nouvelle œuvre est en compétition économique avec l’original. Ce statut donne une viabilité légale pour le détournement artistique et l’appropriation en art. En uniformisant les exceptions, et en créant des possibilités légales de reprises sous certaines conditions, l’U.E. aurait pu limiter les aspects du droit d’auteur qui ont l’impact le plus fort sur la création artistique tout en maintenant la partie permettant au créateurs et créatrices de négocier une rémunération pour la reproduction de l’intégralité de leur travail (puisque le fair use intervient notamment sur des copies partielles et transformées).

Le changement le plus important dans la directive consiste à rendre les plateformes numériques de partage légalement responsables des infractions de droit d’auteurs commises par leurs utilisat·eur·rice·s. Pour l’instant, ce sont les utilisat·eur·rice·s iels-mêmes qui sont responsables de leurs partages : les ayants droit peuvent demander aux plateformes de retirer des contenus, mais ce n’est pas vers elles qu’iels peuvent réclamer des dommages. C’est ce qui va changer avec l’application de la nouvelle directive : ce sont les plateformes qui vont devenir légalement responsables pour des infractions commises par leur utilisat·eur·rice·s. Pour éviter de courir des risques légaux, les plateformes vont devoir commencer à surveiller elles-mêmes les contenus sur leurs sites. Vu le volume des contenus publiés chaque jour, iels n’auront pas d’autre choix que de développer des filtres automatiques. Très controversée, l’obligation d’installer des « upload filters » destinés à filtrer au préalable chaque contenu mis en ligne par les utilisat·eur·rice·s a été enlevée de la directive en dernière minute. Mais il est très probable qu’un contrôle algorithmique des contenus sera le résultat de ces mesures. Cela existe déjà pour la musique : Youtube utilise le système ContentId, Facebook peut supprimer des posts live quand il y est détecté de la musique connue dans leur base de données. Maintenant qu’il existe un réel intérêt financier pour les plateformes, ce genre de système va sûrement voir le jour pour les images. Le déploiement de ces filtres va avoir un grand impact en ligne, et pas seulement parce que les filtres vont détecter des infractions qui n’en sont pas (les « false positives ») : aussi simplement parce qu’une majeure partie des contenus partagés en ligne à l’heure actuelle contient des infractions au droit d’auteur. Quel pourcentage des images partagées sur les réseaux sociaux est une création tout à fait nouvelle ? Reposter des images, des news, des livres, des archives est une pratique courante. Même avant de prendre en compte la création artistique qui dépend beaucoup de la citation et de l’adaptation, la citation visuelle est une partie intégrante du discours en ligne.

On pourrait alors se demander, quel en sera l’impact sur la stratégie de l’obscurité ? Tant que les images sont sur du papier ou dans une exposition, il n’y aura pas beaucoup de risques de filtrage. Mais le monde analogique et numérique sont de plus en plus entrelacés. Il suffira qu’une personne poste une image sur Instagram pour que les algorithmes installés sur les serveurs de ce géant du web puissent faire leur travail : comparer les photos avec une base de données massive fournie par des sociétés de gestion de droits et des autres representant·e·s des ayants droits. On risque alors que les infractions massives aux droit d’auteur commises par la plupart des graphistes-micro-éditeur·ice·s soient repérées. C’est à ce moment-là qu’on va vraiment se rendre compte de l’ampleur du droit d’auteur tel qu’il a été construit au fil des dernières décennies.

Aujourd’hui, la stratégie de la sécurité par l’obscurité commence à perdre son utilité, car on ne pourra bientôt plus ignorer le droit d’auteur. Quelle est alors la solution? D’un point de vue pratique, il me semble d’abord important de bien connaître le droit d’auteur. Cela fait immédiatement sens, parce que c’est un des droits que concerne le plus directement les créati·f·ve·s. De plus, ce n’est pas seulement utile pour comprendre comment copier, c’est aussi indispensable si vous êtes en train de négocier la diffusion de vos propres travaux. Ensuite, d’un point de vue pratique, respecter le droit d’auteur est vraiment la façon la plus simple de ne pas avoir d’ennuis. Même si on ne peut jamais se protéger à 100%, il est au moins possible de prendre des risques calculés.

Si vous tenez à la dimension de réutilisation et de partage, vous pouvez vous tourner vers l’écosystème du libre. Il est tout à fait possible de créer du contenu, de le mettre sous licence libre, et de réutiliser des contenus faits par d’autres publiés également sous licence libre, tout en respectant le droit d’auteur. J’ai passé des années au sein d’une équipe qui s’appelle Open Source Publishing[13], qui travaille de cette manière, et je crois dans la force de cet écosystème.

Mais pour toutes les œuvres que l’auteur.e n’a pas publié sous licence libre, cela reste quand même dommage qu’elles soient pour l’instant interdites de détournement, adaptation et citation sans autorisation préalable. Ainsi, on me demande souvent si je n’ai pas de « tricks ». Mais des tricks, je n’en ai pas. Tant qu’on ne réclame pas son droit de copier, on ne réclame pas pleinement le droit de créer et de publier. La seule option qui reste, c’est alors de militer pour que la législation change[14].

[1] À l’époque j’avais lancé le blog « I like tight pants and mathematics » et je travaillais entre autre avec le designer Australien Simon Pascal Klein et Tom Preston-Werner de la plateforme Github pour développer le dessin collaboratif des polices de caractère.

[2] L’emblématique Art Book Fair de New York n’existe que depuis 2004. En 2019, mon éditeur Onomatope a participé à 26 foires du livre, et seulement deux d’entre elles existaient avant 2010.

[3] Alessandro LUDOVICO, Post-Digital Print, La mutation de l’édition depuis 1894, Éditions B42, 2016.

[4] C’est une entité complète, dont les différentes parties sont littéralement reliées ensembles, et sa lecture ne nécessite habituellement pas d’autre appareil physique que des lunettes.

[5] Un projet de livre demande des investissements à chaque étape du processus ; et de gagner la confiance de mécènes, de pouvoirs subsidiants, d’éditeur.e.s, de diffuseu.rs.ses et de librair.e.s, qui sont tou.s.tes susceptibles d’avoir des préjugés qui restreignent la diversité de l’offre des livres sur le marché, tant au niveau des sujets que des profils des auteur.ice.s publié.e.s. La plateforme numérique « Futuress.org » aborde cette question avec une approche décidément post-numérique. En tant que « feminist library of design books that are yet to be written », le site montre des rendus 3D des livres desquels on peut découvrir le titre et le texte de présentation. Ainsi le projet travaille l’imagination collective.

[6] Matthew G. KIRSCHENBAUM, « The Other End of Print: David Carson, Graphic Design, and the Aesthetics of Media », Media in Transition Conference, MIT, Octobre 8, 1999, [en ligne], https://web.mit.edu/m-i-t/articles/index_kirschenbaum.html.

[7] Historiquement, les réseaux des zines ne dépendent pas de la vente en librairie: ils étaient (et sont encore) envoyés par la poste ou vendus de main à main, lors de concerts, …

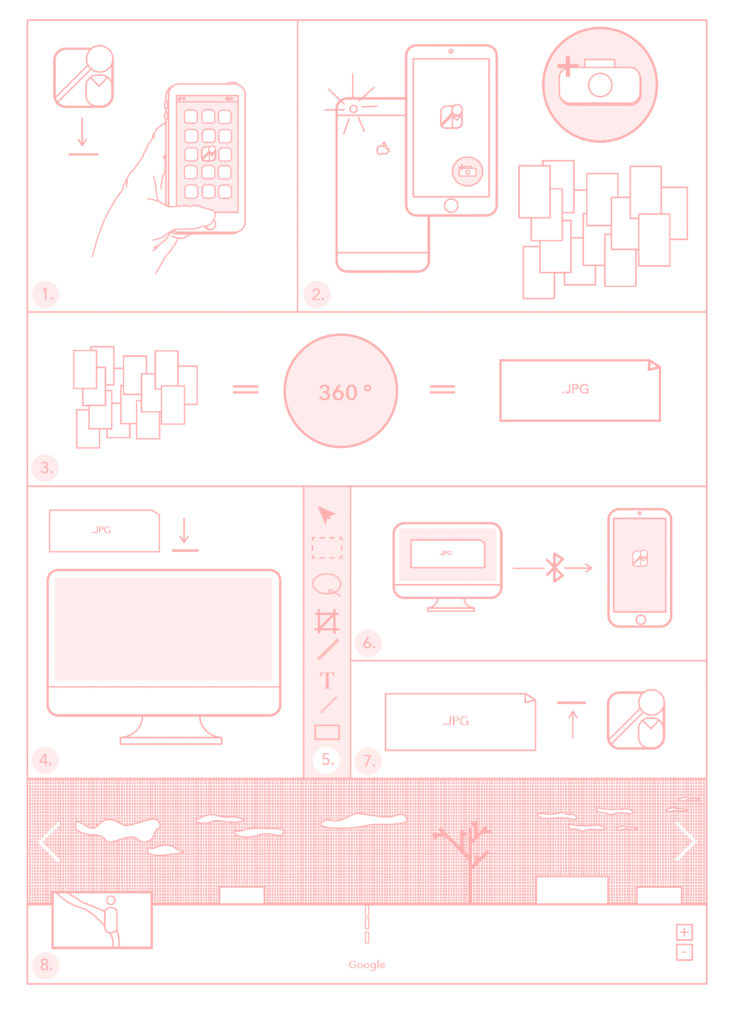

[8] Il y a trop d’exemples à mentionner ici, mais déjà au sein du colloque, Bérénice Serra présentait ses éditions sur des expositions qu’elle organise dans des formats inattendus comme Google Street View (« Résidence », 2018), ou les téléphones de démonstration dans le magasin Fnac (« Galerie », 2016).

[9] Frank PROVOOST, « Het Cassettebandje Is Terug En de Uitvinder Snapt Niet Waarom. », NRC Handelsblad, 15 février 2018, [en ligne], https://www.nrc.nl/nieuws/2018/02/15/het-cassettebandje-is-helemaal-terug-a1592250.

[10] Pour plus de détails sur ces quatre points, voire chapitre 2.2, 5.1, 5.1 et 5.6 du livre Copy This Book, an artist’s guide to copyright (Eric SCHRIJVER, Éditions Onomatopee, 2018).

[11] Malheureusement, restreindre son public veut aussi dire que son contenu touche moins de personnes. Il s’agit donc d’une forme d’auto-censure.

[12] Concernant les limites de la citation visuelle et les différences entre jurisprudence belge et française, cet article montre en détail comment, dans le cadre européen, les exceptions au droit d’auteur offrent une marge de manœuvre très restreinte : Julien CABAY, Maxime LAMBRECHT, « Remix Prohibited: How Rigid EU Copyright Laws Inhibit Creativity », Journal of Intellectual Property Law & Practice 10, n° 5, 01 mai 2015, pp. 359–77, [en ligne],

https://doi.org/10.1093/jiplp/jpv015

[13] Open Source Publishing est un collectif bruxellois qui pratique depuis 2008 le design graphique, l’enseignement et la recherche avec un focus sur l’impact des outils numériques, en utilisant que des logiciels libres, [en ligne], https://osp.kitchen

[14] Remerciements : Merci à Loraine Furter pour la relecture et les conseils dans l’établissement de ce texte.

—

Résumé

Dans un monde où presque aucune activité humaine n’échappe aux programmes numériques, ces derniers prennent un caractère existentiel et engendrent un assujettissement du vivant à des logiques d’automation. Il en résulte un profond déséquilibre des milieux de vie (théories de l’effondrement, perte de la biodiversité, etc.) et une perte de sens de l’existence. Afin de cerner le concept de programme, nous associerons trois champs tendant à converger : le design, l’informatique et la biologie. Ce rapprochement permettra de formuler trois perspectives écologiques non binaires – autant de scénarios qui contestent le présupposé d’un design comme plan et qui le redéfinissent comme « art de l’équilibre », « zone de trouble », et « variation d’insignifiant ».

Texte écrit en 2020, actualisé en 2021 pour compléter les actes du colloque « Les écologies du numérique » organisé par l’Ésad Orléans (ÉCOLAB) en 2017 et 2018.

—

Mots clé

Biologie, Code, Design, Écologie, Génétique, Physique, Programmation, Programme

—

Biographies

Anthony Masure est responsable de la recherche à la Haute École d’Art et de Design de Genève (HEAD – Genève, HES-SO). Agrégé d’arts appliqués et ancien élève du département design de l’ENS Paris-Saclay, il est membre associé du laboratoire LLA-CRÉATIS de l’université Toulouse – Jean Jaurès. Ses recherches portent sur les implications sociales, politiques et esthétiques des technologies numériques. Il a cofondé les revues de recherche Back Office et Réel-Virtuel, et est l’auteur de l’essai Design et humanités numériques (éd. B42, 2017). Site Web : http://www.anthonymasure.com

Élise Rigot est agrégée d’arts appliqués, ancienne élève du département Design de l’ENS Paris-Saclay et diplômée de l’école Boulle. Elle est chargée de cours à l’université Toulouse − Jean Jaurès. Son sujet de thèse de doctorat en design (LLA-CRÉATIS et LAAS-CNRS) porte sur les f(r)ictions entre le design et les nano-bio-technologies. Elle est l’auteure d’un podcast, Bio Is The New Black, autour du design et des technologies de bio-fabrication. Elle publie dans la revue Sciences du design. Site Web : http://eliserigot.com

« En ce temps, en prévision des mutations à venir, d’obscurs constructeurs modelaient les images prématurées d’un futur éventuel très lointain.[1] »

Dans son recueil de nouvelles Cosmicomics (1965), l’écrivain Italo Calvino élabore une cosmologie hantée par des êtres polyformes, dont les soubresauts peuvent faire écho à l’ambition démiurgique du design. En effet, la faculté du design de pouvoir créer tous les objets possibles (« de la cathédrale à la petite cuillère[2] »), renvoie en creux à la volonté de façonner une réalité complexe et incertaine en adéquation avec un plan : les choses engendrent des comportements[3] (behavioral design) et dessinent des cadres permettant plus ou moins de liberté[4]. Cette définition commune du design comme « plan » (comme dessein) recoupe la définition d’un « programme », à savoir une suite d’actions visant un objectif déterminé.

La logique opératoire du programme est aujourd’hui omniprésente : depuis le développement à grande échelle des programmes informatiques, des laboratoires technoscientifiques (bio-impression, biologie synthétique, CRISPR CAS9, etc.), jusqu’au dessin des modes de vie. Cerner la notion de programme implique donc de rapprocher les trois champs que sont le design, l’informatique et la biologie. Mais si le monde entier devient un programme (un projet), qui décide, ou non, des conditions de l’équilibre entre les milieux humains et non humains, et selon quelles valeurs ? La notion de programme supposant une écriture « à l’avance » (pro-gramme), comment conjuguer l’élaboration de règles et de procédures propres aux pratiques de programmation avec le caractère incontrôlable du vivant ? La notion de programmation, « appliquée » au vivant, pourrait-elle redéfinir ce que l’on attend habituellement du design ?

Pour y voir plus clair dans ces enjeux et tracer quelques lignes de fuite, nous établirons tout d’abord une rapide généalogie de la notion de programme en croisant l’histoire de l’informatique et de la biologie pour montrer comment elle prend un sens politique voire existentiel. Nous verrons ensuite comment le design peut œuvrer à échapper à la logique fonctionnaliste et aux conséquences écologiques liées au déséquilibre des milieux (« 6e extinction », théorie de l’effondrement, perte de la biodiversité, etc.) qu’elle entraîne. Autrement dit : comment penser la notion de programme depuis des perspectives écologiques ?

« Programme » apparaît dans le dictionnaire autour de 1680. Dérivé du grec programma, de pro, « avant » et gramma, « ce qui est écrit », il peut se comprendre littéralement comme « ce qui est écrit à l’avance ». Avec l’émergence des médias de masse au début du XXe siècle, ce mot en vient à qualifier ce qui est annoncé en amont d’un objet temporel destiné à une large audience (radio, TV, etc.). Mais un autre sens, issu de la Révolution française (1789), mérite d’être examiné : c’est à cette époque que le terme de programme prend le sens d’« exposé général des intentions et projets politiques (d’une personne, d’un groupe) ». Il en vient alors, par extension, à désigner une suite d’actions que l’on prévoit d’accomplir en vue d’un résultat : « Le mot a développé des emplois didactiques en art, économie, architecture et musique avec le sens de base, « ensemble de conditions à remplir, de contraintes à respecter ». Il est en concurrence partielle avec plan. »

Avec l’invention d’un des premiers calculateurs, l’ENIAC (Electronic Numerical Integrator And Computer, 1945), la notion de programme se lie à l’informatique. Le « master programmer » (programme principal) désigne alors le composant électronique en charge de contrôler le bon fonctionnement de chaque unité de la machine[5]. Par analogie aux personnes réalisant la « mise en place » de l’ENIAC (via des actions de câblage et décâblage de la machine pour résoudre des problèmes particuliers[6]), le mot « programmeur » apparaît pour caractériser non pas des éléments machiniques, mais des êtres humains. Toujours avec le développement des ordinateurs, le terme de programme change de sens, passant de « ce qui est transmis » (sens dérivé du « signal de programme » de l’ingénierie électronique) à « ce qui est responsable de l’exécution ». En France (1954), Raymond Ruyer définit le programme comme un « ensemble de dispositions déterminant l’ordre de fonctionnement d’une machine électronique[7] ». Dans l’entrée « Programmability » (programmabilité) de l’ouvrage Software Studies: A lexicon (2008), la chercheuse Wendy Hui Kyong Chun souligne ce qui sépare le programme (de l’ENIAC) de la programmation (des ordinateurs) : « La programmation d’un ordinateur analogique est descriptive ; la programmation d’un ordinateur numérique est prescriptive[8] ». En effet, dans la lignée des travaux de l’informaticien John Von Neumann, il est possible de définir un programme numérique comme un ensemble de règles stockées dans la machine (mis en mémoire), et donc d’appréhender le programme comme une suite d’écritures précédant (prescrivant) une action ou un comportement. Avec la prescription, le programme devient un donneur d’ordres et d’ordonnances de contrôle. Le programme impose un plan où la liberté n’a guère de place.

Avec le développement de l’informatique, la notion de programme ne s’applique plus seulement aux machines. Organismes, algorithmes génétiques, biodiversité technologique, etc., ces nouvelles matérialités du vivant exigent d’être attentif au milieu à la fois artificiel et naturel créé par les humains : celui-ci doit-il être programmé au sens d’un plan prescriptif ? Comment envisager, pour reprendre les mots de l’artiste Louis Bec, « le devenir d’un vivant indissociable de la liberté[9] » ? Existe-t-il un programme régissant le fonctionnement voire l’évolution du vivant ?

La question de l’évolution et de l’hérédité, qui renvoie directement à la possibilité d’un programme non pas électronique mais génétique, trouve son origine dans l’ouvrage What is Life ?[10] (1944), dans lequel le physicien Erwin Schrödinger postule l’existence d’un « code génétique » pour expliquer la présence d’un ordre à l’échelle microscopique, là où les lois de la physique traditionnelle ne s’appliquent pas : « Ce sont ces chromosomes […] qui contiennent sous la forme d’une espèce de code [code-script][11], le modèle intégral [pattern] du développement futur de l’individu et de son fonctionnement à l’état adulte[12]. » Il ajoute plus loin que « le terme code est […] trop étroit. Les structures chromosomiques servent en même temps à réaliser le développement qu’ils symbolisent. Ils sont le code loi [law code] et le pouvoir exécutif […], ils sont à la fois le plan de l’architecte et l’œuvre d’art de l’entrepreneur [builder’s craft][13] ».

À la suite de ce modèle du mécanisme héréditaire énoncé depuis la physique vers la biologie, l’école de la biologie moléculaire française (dont François Jacob, André Lwoff et Jacques Monod[14]) va opposer aux principes déterministes d’une conception mécanique du vivant le concept d’un « programme de l’hérédité », dans une formulation faisant écho au code informatique. La logique du vivant[15] (1970), un ouvrage d’histoire de la biologie rédigé par François Jacob, décrit ainsi l’hérédité en termes d’informations, de messages et de codes : « L’organisme devient ainsi la réalisation d’un programme prescrit par l’hérédité[16] ». Ici, l’exécution d’un dessein, d’un plan, n’a pas été réalisée par un programmateur humain mais répond à l’exigence de la reproduction de l’espèce. Ce programme est le fruit du hasard et des rencontres de l’organisme avec son milieu : « Le programme représente un modèle emprunté aux calculatrices électroniques. Il assimile le matériel génétique d’un œuf à la bande magnétique d’un ordinateur[17] » On pourrait y voir un rapprochement évident entre la cybernétique et la biologie moléculaire, proches historiquement, Jacob citant Norbert Wiener[18], père de la cybernétique[19]. Pourtant, selon l’école de la biologie moléculaire, on ne saurait expliquer la logique du vivant depuis un cadre déterministe voire mécanique : « La notion cybernétique de programme maintient de facto le vivant dans un cadre mécaniste où l’on procède nécessairement des parties vers le tout comme le ferait un horloger, en droite ligne avec le postulat de l’animal-machine de Descartes[20] ». Au pilotage cybernétique s’oppose le concept de « milieu ». François Jacob note ainsi que : « dans le programme sont contenues les opérations qui […] conduisent chaque individu de la jeunesse à la mort. […] Tout n’est pas fixé avec rigidité par le programme génétique. Bien souvent, celui-ci ne fait qu’établir des limites à l’action du milieu[21] ». Plus précisément, la notion de notion de « programme » de l’hérédité est établie par l’école de la biologie moléculaire pour rendre compte d’une histoire de l’évolution, inscrite au cœur de chaque cellule, et permettant à chaque entité vivante de transmettre des informations à la génération suivante. À mesure que le temps géologique passe, ce programme s’affine afin de permettre aux êtres vivants de se reproduire. François Jacob souligne la différence entre le programme génétique biologique et le programme informatique dès le début de son ouvrage[22] : le matériel génétique de la cellule n’est pas modifiable et s’appuie sur une organisation structurelle améliorante, tandis que la bande magnétique est réinscriptible, non structurelle, et ne peut pas s’améliorer toute seule. Établie en 1970 – soit donc à l’aube de l’informatique personnelle –, cette distinction est-elle toujours valable ?

Depuis les recherches de l’école de la biologie moléculaire, la situation technique a changé, rendant sans doute cette partition inopérante. Contrairement au caractère ancestral du « programme de l’hérédité », les modifications du génome (biologie synthétique) montrent que le code génétique peut être « édité » par l’action humaine. On pourrait en premier lieu penser aux OGM (Organismes Génétiquement Modifiés) apparus depuis les années 1990, qui consistent à introduire dans un organisme un fragment du génome d’une autre espèce. Plus proche de nous, « l’édition génétique » de CRISPR se « contente » de modifier un gène, parfois très légèrement, pour « accélérer » son évolution dans un sens planifié. Les applications de CRISPR sur l’être humain pourraient ainsi permettre l’augmentation de la capacité musculaire ou l’éradication de maladies génétiques[23]. Ces exemples sont largement controversés, que ce soit dans les pratiques d’édition ou de modification génétiques, et tendent à montrer l’absence de prise en compte de la notion de « milieu » dans ces savoir-faire technoscientifiques.

Un travail entre art et design permet d’éclairer ces enjeux. Dans le projet Human × Shark[24] (2017), la designeuse Ai Hasegawa détourne l’imaginaire du « post-humain » – souvent caucasien et masculin –, et cherche à produire une relation inter-espèce avec un requin. Elle crée en laboratoire un fluide pouvant attirer des requins mâles et se filme dans l’eau avec eux lors d’une plongée sous-marine. La vidéo est accompagnée d’une installation de deux fragrances favorisant l’accouplement. Cette œuvre fait écho au récent développement d’« organes-sur-puce[25] » ou de flacons micro-fluidiques, faisant de la biotechnologie une possibilité d’hybridation et de collage du vivant.

Un autre exemple de rapprochement (voire de confusion) entre programme informatique et biologique réside dans les typologies contemporaines des « intelligences artificielles », à savoir celles du deep learning[26] (« apprentissage profond »). Ces dernières incarnent un changement de paradigme, où les règles ne sont plus écrites à l’avance, mais résultent de la comparaison de jeux de données « étiquetées » et « brutes » par des suites d’essais/erreurs. Dans cette logique, l’intervention humaine consiste à mettre en place les conditions de génération du programme. Il en résulte une impossibilité d’expliquer son fonctionnement – la seule chose qui compte (et qui est mesurable) étant son efficacité dans une situation donnée. Ces programmes informatiques d’un nouveau type peuvent, en un sens, être compris comme des entités vivantes dont on ne pourrait étudier que les corrélations entre les entrées (inputs) et les sorties (outputs). Les technologies du deep learning sont d’ailleurs désormais utilisées pour classer le génome ou les maladies[27]. On pourrait aussi mentionner le développement des biopuces, dans les années 1990, capables de transformer une réaction biologique en signal électronique[28].

Ces quelques éléments montrent qu’il faut envisager la notion de programme dans un sens élargi et comme condition existentielle. Si la distinction entre informatique et biologie n’opère plus, c’est que la mise en programme du monde révèle des convergences entre disciplines scientifiques : le bit informatique rencontre le gène biologique. Cette réalité est tout autant présente dans les pratiques que dans le langage. François Jacob se demandait en 1970, quels modèles langagiers régiraient la science de demain. Le programme donne vie à des grandes métaphores, telles que le gène dans l’histoire de la biologie[29], ou le code dans celui de l’informatique. Si les frontières qui séparaient les programmes biologiques et numériques tendent à disparaître, des études systémiques et écologiques se méfient de ces métaphores qu’elles jugent réductionnistes. Celles-ci construisent ouvrent autant de possibles qu’elles ne réduisent l’organisme à une suite alphanumérique. La « convergence » entre design, informatique et biologie n’est d’ailleurs pas un fait anodin ; l’idée d’une unification des sciences revient souvent dans le discours des technosciences comme un moyen d’augmenter les performances humaines[30].

Afin de comprendre en quoi le programme engage une dimension plus large que la résolution de problèmes via une suite d’actions ou que l’adaptation d’un être vivant à un milieu pour favoriser sa reproduction, il est utile d’examiner des textes rédigés en français par le théoricien des médias Vilém Flusser à partir du milieu des années 1970[31]. Son essai Post-histoire[32] (1982) s’ouvre sur l’évènement « incomparable » d’Auschwitz, que Flusser comprend, à la suite des philosophes Hannah Arendt et Günther Anders, comme l’aboutissement de la modernité : « Le camp d’extermination est occidental parce qu’il pousse directement des racines mêmes de l’Occident, de ses concepts et de ses valeurs. Auschwitz est implicitement contenu dans le projet initial de notre culture. Dans son < programme >[33] ». Pour Flusser, celui-ci fait de nous des « fonctionnaires » : il nous déresponsabilise de de nos actes et enlève le sens du travail pour faire de nous les rouages d’une machine plus vaste. L’entrée « Programme » de Post-histoire précise cette pensée. Selon Flusser, cette notion se substitue aux anciennes conceptions du monde, à savoir à la pensée finaliste (de la religion) et à la pensée causale (de la science). Plus précisément, Flusser redéfinit la notion de programme depuis la biologie moléculaire[34] : « Pour l’anthropologie programmatique l’homme est une permutation parmi d’autres permutations, de l’information génétique, commune à tout être vivant, et qui s’est réalisée par le jeu accidentel des gènes[35] » ; « Pour l’éthique programmatique le comportement humain est le déroulement de manifestations accidentelles des virtualités latentes dans l’homme et dans son milieu[36] » ; « [La pensée programmatique] applique à l’anthropologie le modèle de biologie moléculaire, selon lequel la structure de certain acides nucléaires contient toutes les formes possibles des organismes[37] ». Là où le programme de l’hérédité suppose l’existence d’un code favorisant la reproduction via l’adaptation à un milieu, Flusser l’examine du point de vue humain pour en faire non pas seulement une question de vie (de persistance dans le monde), mais d’existence (de sens et de non sens) : « Un programme c’est un système où toute virtualité inhérente se réalise par hasard, mais nécessairement. Il est un jeu[38] » – une telle formule peut se rapprocher des théories du biologiste Jacques Monod décrite dans l’ouvrage Le Hasard et la nécessité[39].

Flusser souligne la condition contemporaine régie par les programmes sous l’égide de l’’absurdité. C’est précisément cette tension entre hasard et nécessité qui intéresse Flusser, à savoir le caractère absurde d’une existence qui ne connaît pas les règles qui régissent son jeu. Il est vain de chercher à se libérer ou à s’émanciper des programmes car ces verbes perdent leur sens dans une pensée non finaliste : lire ou « démythifier », les programmes font de nous des fonctionnaires. Selon Flusser, ceux qui écrivent les instructions des programmes (les programmeurs) n’y échappent pas, d’une part car ils sont eux-mêmes programmés et, d’autre part car les appareils tendent à devenir « intelligents » et produisent des programmes sans intervention humaine (cette intuition se réalisera dans le développement des technologies de machine learning). Par conséquent, nous n’avons d’autre choix que de jouer avec les programmes. Il nous faut accepter cette absurdité pour éviter de devenir les pions d’un jeu gigantesque ; « programmer ou être programmé[40] ». Dans ce contexte, les artistes et designers peuvent détourner les programmes de leur fatalité. L’artiste Grégory Chatonsky, dans ses recherches sur « l’imagination artificielle », questionne par exemple la part créative des intelligences artificielles. Dans la vidéo I’m only memory and I love only you (2019), l’artiste détourne une base de données d’images prise sur les réseaux sociaux et donne à voir une métamorphose à la fois belle et monstrueuse de mémoires et d’histoires de vie numériques.

Alors que Flusser ouvrait Post-histoire par le cas d’Auschwitz, et que Günther Anders voyait dans la « condition atomique » la fin de l’histoire universelle[41], le programme occidental menace à présent non seulement les êtres humains, mais l’ensemble du vivant – qu’on pense par exemple au rapport Meadows (1972), à la « 6e extinction » ou aux théories de l’effondrement[42], soit donc un déséquilibre complet des milieux de vie. S’il faut apprendre à « vivre dans les programmes[43] », ces derniers doivent donc s’ancrer dans des conditions laissant les être vivants (et pas seulement humains), « vivre ». D’autre part, la « condition programmatique » invite à dépasser la situation de subsistance (la vie limitée à la reproduction de l’espèce) pour accéder à l’existence[44], c’est-à-dire la capacité à dépasser une situation initiale : de transformer le programme.

Dans cette visée, l’assimilation du design à un plan, selon sa définition habituelle évoquée en introduction, est inopérante pour opérer de tels renversements. Aussi, nous proposons à l’inverse de comprendre le design comme ce qui permet d’affronter l’absurdité des programmes. Autrement dit, le design est moins ce qui façonne le monde depuis une suite d’instructions que ce qui permet de jouer, et donc d’exister, c’est-à-dire d’affronter l’entropie et la réalisation de chaque futur possible (il n’est pas souhaitable que chaque virtualité advienne au monde). Nous proposons, en guise d’ouverture, trois pistes pour des scénarios « non binaires », soit trois façons de jouer avec les programmes.